1. はじめに

1.1. 利用規約

本ドキュメントを使用するにあたり、以下の規約に同意していただく必要があります。同意いただけない場合は、本ドキュメント及びその複製物の全てを直ちに消去又は破棄してください。

-

本ドキュメントの著作権及びその他一切の権利は、NTTデータあるいはNTTデータに権利を許諾する第三者に帰属します。

-

本ドキュメントの一部または全部を、自らが使用する目的において、複製、翻訳、翻案することができます。ただし本ページの規約全文、およびNTTデータの著作権表示を削除することはできません。

-

本ドキュメントの一部または全部を、自らが使用する目的において改変したり、本ドキュメントを用いた二次的著作物を作成することができます。ただし、「参考文献:TERASOLUNA Batch Framework for Java (5.x) Development Guideline」あるいは同等の表現を、作成したドキュメント及びその複製物に記載するものとします。

-

前2項によって作成したドキュメント及びその複製物を、無償の場合に限り、第三者へ提供することができます。

-

NTTデータの書面による承諾を得ることなく、本規約に定められる条件を超えて、本ドキュメント及びその複製物を使用したり、本規約上の権利の全部又は一部を第三者に譲渡したりすることはできません。

-

NTTデータは、本ドキュメントの内容の正確性、使用目的への適合性の保証、使用結果についての的確性や信頼性の保証、及び瑕疵担保義務も含め、直接、間接に被ったいかなる損害に対しても一切の責任を負いません。

-

NTTデータは、本ドキュメントが第三者の著作権、その他如何なる権利も侵害しないことを保証しません。また、著作権、その他の権利侵害を直接又は間接の原因としてなされる如何なる請求(第三者との間の紛争を理由になされる請求を含む。)に関しても、NTTデータは一切の責任を負いません。

本ドキュメントで使用されている各社の会社名及びサービス名、商品名に関する登録商標および商標は、以下の通りです。

-

TERASOLUNA は、株式会社NTTデータの登録商標です。

-

その他の会社名、製品名は、各社の登録商標または商標です。

1.2. 導入

1.2.1. ガイドラインの目的

本ガイドラインではSpring Framework、Spring Batch、MyBatis を中心としたフルスタックフレームワークを利用して、 保守性の高いバッチアプリケーション開発をするためのベストプラクティスを提供する。

本ガイドラインを読むことで、ソフトウェア開発(主にコーディング)が円滑に進むことを期待する。

1.2.2. ガイドラインの対象読者

本ガイドラインはソフトウェア開発経験のあるアーキテクトやプログラマ向けに書かれており、 以下の知識があることを前提としている。

-

Spring FrameworkのDIやAOPに関する基礎的な知識がある

-

Javaを使用してアプリケーションを開発したことがある

-

SQLに関する知識がある

-

Mavenを使用したことがある

これからJavaを勉強し始めるという人向けではない。

Spring Frameworkに関して、本ドキュメントを読むための基礎知識があるかどうかを測るために Spring Framework理解度チェックテスト を参照するとよい。 この理解度テストが4割回答できない場合は、別途以下のような書籍で学習することを推奨する。

1.2.3. ガイドラインの構成

まず、重要なこととして、本ガイドラインは TERASOLUNA Server Framework for Java (5.x) Development Guideline (以降、TERASOLUNA Server 5.x 開発ガイドライン)のサブセットとして位置づけている。 出来る限りTERASOLUNA Server 5.x 開発ガイドラインを活用し説明の重複を省くことで、ユーザの学習コスト低減を狙っている。 よって随所にTERASOLUNA Server 5.x 開発ガイドラインへの参照を示しているため、両方のガイドを活用しながら開発を進めていってほしい。

- TERASOLUNA Batch Framework for Java (5.x)のコンセプト

-

バッチ処理の基本的な考え方、TERASOLUNA Batch Framework for Java (5.x)の基本的な考え方、Spring Batchの概要を説明する。

- アプリケーション開発の流れ

-

TERASOLUNA Batch Framework for Java (5.x)を利用してアプリケーション開発する上で必ず押さえておかなくてはならない知識や作法について説明する。

- ジョブの起動

-

同期実行、非同期実行、起動パラメータといったジョブの起動方法について説明する。

- データの入出力

-

データベースアクセス、ファイルアクセスといった、各種リソースへの入出力について説明する。

- 異常系への対応

-

入力チェックや例外ハンドリングといった異常系について説明する。

- ジョブの管理

-

ジョブの実行管理の方法について説明する。

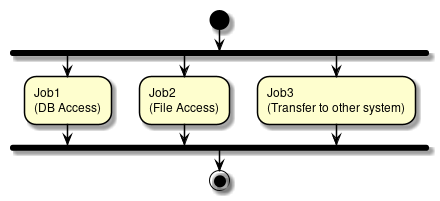

- フロー制御と並列・多重処理

-

ジョブを並列処理/分散処理する方法について説明する。

1.2.4. ガイドラインの読み方

以下のコンテンツはTERASOLUNA Batch Framework for Java (5.x)を使用するすべての開発者が読むことを強く推奨する。

以下のコンテンツは通常必要となるため、基本的には読んでおくこと。 開発対象に応じて、取捨選択するとよい。

以下のコンテンツは一歩進んだ実装をする際にはじめて参照すれば良い。

1.2.4.1. ガイドラインの表記

本ガイドラインの表記について、留意事項を述べる。

- WindowsコマンドプロンプトとUnix系ターミナルについて

-

WindowsとUnix系では表記の違いで動作しなくなる場合は併記する。 そうでない場合は、Unix系の表記で統一する。

- プロンプト記号

-

Unix系の

$にて表記する。

$ java -version- Bean定義のプロパティとコンストラクタについて

-

本ガイドラインでは、

pとcのネームスペースを用いた表記とする。 ネームスペースを用いることで、Bean定義の記述が簡潔になったり、コンストラクタ引数が明確になる効果がある。

<bean class="org.springframework.batch.item.file.mapping.DefaultLineMapper">

<property name="lineTokenizer">

<bean class="org.terasoluna.batch.item.file.transform.FixedByteLengthLineTokenizer"

c:ranges="1-6, 7-10, 11-12, 13-22, 23-32"

c:charset="MS932"

p:names="branchId,year,month,customerId,amount"/>

</property>

</bean>参考までに、ネームスペースを利用しない記述を示す。

<bean class="org.springframework.batch.item.file.mapping.DefaultLineMapper">

<property name="lineTokenizer">

<bean class="org.terasoluna.batch.item.file.transform.FixedByteLengthLineTokenizer">

<constructor-arg index="0" value="1-6, 7-10, 11-12, 13-22, 23-32"/>

<constructor-arg index="1" value="MS932"/>

<property name="names" value="branchId,year,month,customerId,amount"/>

</property>

</bean>なお、ユーザに対してネームスペースを用いる記述を強要することはない。 あくまで説明を簡潔にするための配慮であると受け止めてほしい。

1.2.5. ガイドラインの動作検証環境

本ガイドラインで説明している内容の動作検証環境については、 「 テスト済み環境 」を参照されたい。

2. TERASOLUNA Batch Framework for Java (5.x)のコンセプト

2.1. 一般的なバッチ処理

2.1.1. 一般的なバッチ処理とは

一般的に、バッチ処理とは「まとめて一括処理する」ことを指す。

データベースやファイルから大量のレコードを読み込み、処理し、書き出す処理であることが多い。

バッチ処理には以下の特徴があり、オンライン処理と比較して、応答性より処理スループットを優先した処理方式である。

-

データを一定の量でまとめて処理する。

-

処理に一定の順序がある。

-

スケジュールに従って実行・管理される。

次にバッチ処理を利用する主な目的を以下に示す。

- スループットの向上

-

データをまとめて処理することで、処理のスループットを向上できる。

ファイルやデータベースは、1件ごとにデータを入出力せず、一定件数にまとめることで、I/O待ちのオーバヘッドが劇的に少なくなり効率的である。 1件ごとのI/O待ちは微々たるものでも、大量データを処理する場合はその累積が致命的な遅延となる。 - 応答性の確保

-

オンライン処理の応答性を確保するため、即時処理を行う必要がない処理をバッチ処理に切り出す。

たとえば、すぐに処理結果が必要でない場合、オンライン処理で受付まで処理を行い、裏でバッチ処理を行う構成がある。 このような処理方式は、ディレードバッチ、ディレードオンラインなどと呼ばれる。 - 時間やイベントへの対応

-

特定の時間やイベントに応じた処理は、バッチ処理として実装することが素直と言える。

たとえば、業務要件により1ヶ月分のデータを翌月第1週の週末に集計する、システム運用ルールに則って週末日曜の午前2時に1週間分の業務データをバックアップする、などである。 - 外部システムとの連携上の制約

-

ファイルなど外部システムとのインターフェースが制約となるために、バッチ処理を利用することもある。

外部システムから送付されてきたファイルは、一定期間のデータをまとめたものになる。 これを取り込む処理は、オンライン処理よりもバッチ処理が向いている。

バッチ処理を実現するには、さまざまな技術要素を組み合わせることが一般的である。ここでは、主要な技術を紹介する。

- ジョブスケジューラ

-

バッチ処理の1実行単位をジョブと呼ぶ。これを管理するためのミドルウェアである。

バッチシステムにおいて、ジョブが数個であることは稀であり、通常は数百、ときには数千にいたる場合もある。 そのため、ジョブの関連を定義し、実行スケジュールを管理する専用の仕組みが不可欠になる。 - シェルスクリプト

-

ジョブを実現する方法の1つ。OSやミドルウェアなどに実装されているコマンドを組み合わせて1つの処理を実現する。

手軽に実装できる反面、複雑なビジネスロジックを記述するには不向きであるため、ファイルのコピー・バックアップ・テーブルクリアなど主にシンプルな処理に用いる。 また、別のプログラミング言語で実装した処理を実行する際に、起動前の設定や実行後の処理だけをシェルスクリプトが担うことも多い。 - プログラミング言語

-

ジョブを実現する方法の1つ。シェルスクリプトよりも構造化されたコードを記述でき、開発生産性・メンテナンス性・品質などを確保するのに有利である。 そのため、比較的複雑なロジックになりやすいファイルやデータベースのデータを加工するようなビジネスロジックの実装によく使われる。

2.1.2. バッチ処理に求められる要件

業務処理を実現するために、バッチ処理に求められる要件には以下のようなものがある。

-

性能向上

-

一定量のデータをまとめて処理できる。

-

ジョブを並列/多重に実行できる。

-

-

異常発生時のリカバリ

-

再実行(手動/スケジュール)ができる。

-

再処理した時に、処理済レコードのスキップして、未処理部分だけを処理できる。

-

-

多様な起動方式

-

同期実行ができる。

-

非同期実行ができる。

-

実行契機としては、DBポーリング、HTTPリクエスト、などがある。

-

-

-

さまざまな入出力インターフェース

-

データベース

-

ファイル

-

CSVやTSVなどの可変長

-

固定長

-

XML

-

-

上記の要件について具体的な内容を以下に示す。

- 大量データを一定のリソースで効率よく処理できる(性能向上)

-

大量のデータをまとめて処理することで処理時間を短縮する。このとき重要なのは、 「一定のリソースで」 の部分である。

100万件でも1億件でも、一定のCPUやメモリの使用で処理でき、件数に応じて緩やかにかつリニアに処理時間が延びるのが理想である。 まとめて処理するには、一定件数ごとにトランザクションを開始・終了させ、まとめてI/O入出力しすることで、 使用するリソースを平準化させる仕組みが必要となる。

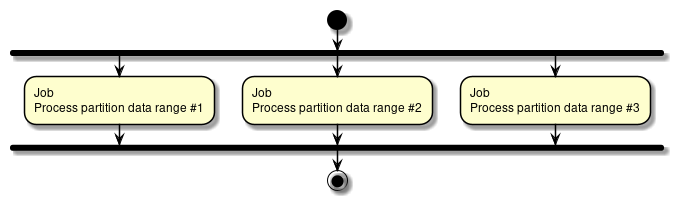

それでも処理しきれない膨大なデータを相手にする場合は、一歩進んでハードウェアリソースを限界まで使い切る仕組みも追加で必要になる。 処理対象データを件数やグループで分割して、複数プロセス・複数スレッドによって多重処理する。 さらに推し進めて複数マシンによる分散処理をすることもある。 リソースを限界まで使い切る際には、I/Oを限りなく低減することがきわめて重要になる。 - 可能な限り処理を継続する(異常発生時のリカバリ)

-

大量データを処理するにあたって、入力データが異常な場合や、システム自体に異常が発生した場合の防御策を考えておく必要がある。

大量データは必然的に処理し終わるまでに長時間かかるが、エラー発生後に復旧までの時間が長期化すると、システム運用に大きな影響を及ぼしてしまう。

たとえば、1000万件のデータを処理する場合を考える。999万件目でエラーになり、それまでの処理をすべてやり直すとしたら、 運用スケジュールに影響が出てしまうことは明白である。

このような影響を抑えるために、バッチ処理ならではの処理継続性が重要となる。これにはエラーデータをスキップしながら次のデータを処理する仕組み、 処理をリスタートする仕組み、可能な限り自動復旧を試みる仕組み、などが必要となる。また、1つのジョブを極力シンプルなつくりにし、再実行を容易にすることも重要である。 - 実行契機に応じて柔軟に実行できる(多様な起動方式)

-

時刻を契機とする場合、オンラインや外部システムとの連携を契機とした場合など、さまざまな実行契機に対応するの仕組みが必要になる。 同期実行ではジョブスケジューラから定時になったら処理を起動する、 非同期実行ではプロセスを常駐させておきイベントに応じて随時バッチ処理を行う、というような 様々な仕組みが一般的に知られている。

- さまざまな入出力インターフェースを扱える(さまざまな入出力インターフェース)

-

オンラインや外部システムと連携するということは、データベースはもちろん、CSV/XMLといったさまざまなフォーマットのファイルを扱えることが重要となる。 さらに、それぞれの入出力形式を透過的に扱える仕組みがあると実装しやすくなり、複数フォーマットへの対応も迅速に行なえるようになる。

2.1.3. バッチ処理で考慮する原則と注意点

バッチ処理システムを構築する際に考慮すべき重要な原則、および、いくつかの一般的な考慮事項を示す。

-

単一のバッチ処理は可能な限り簡素化し、複雑な論理構造を避ける。

-

処理とデータは物理的に近い場所におく(処理を実行する場所にデータを保存する)。

-

システムリソース(特にI/O)の利用を最小限にし、できるだけインメモリで多くの操作を実行する。

-

また、不要な物理I/Oを避けるため、アプリケーションのI/O(SQLなど)を見直す。

-

複数のジョブで同じ処理を繰り返さない。

-

たとえば、集計処理とレポート処理がある場合に、レポート処理で集計処理を再度することは避ける。

-

-

常にデータの整合性に関しては最悪の事態を想定する。十分なチェックとデータの整合性を維持するために、データの検証を行う。

-

バックアップについて十分に検討する。特にシステムが年中無休で実行されている場合は、バックアップの難易度が高くなる。

2.2. TERASOLUNA Batch Framework for Java (5.x)のスタック

2.2.1. 概要

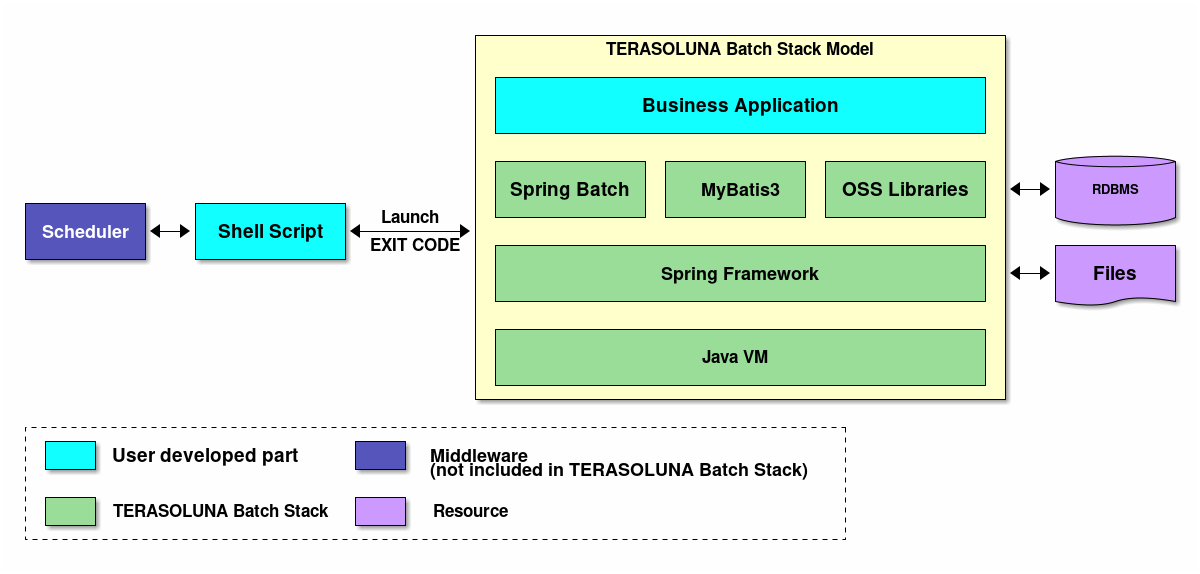

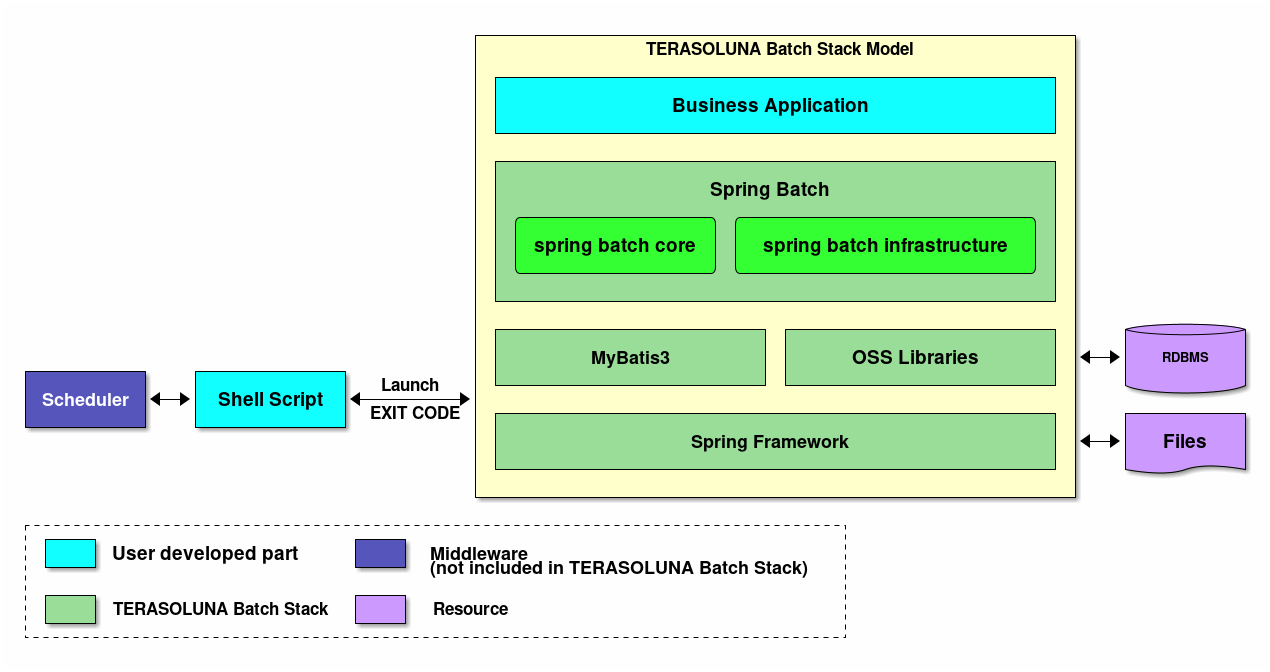

TERASOLUNA Batch Framework for Java (5.x)の構成について説明し、TERASOLUNA Batch Framework for Java (5.x)の担当範囲を示す。

2.2.2. TERASOLUNA Batch Framework for Java (5.x)のスタック

TERASOLUNA Batch Framework for Java (5.x)で使用するSoftware Frameworkは、 Spring Framework (Spring Batch) を中心としたOSSの組み合わせである。以下にTERASOLUNA Batch Framework for Java (5.x)のスタック概略図を示す。

ジョブスケジューラやデータベースなどの製品についての説明は、本ガイドラインの説明対象外とする。

2.2.2.1. 利用するOSSのバージョン

TERASOLUNA Batch Framework for Java (5.x)のバージョン5.0.0.RELEASEで利用するOSSのバージョン一覧を以下に示す。

|

TERASOLUNA Batch Framework for Java (5.x)で使用するOSSのバージョンは、原則として、Spring IO platformの定義に準じている。

なお、バージョン5.0.0.RELEASEにおけるSpring IO platformのバージョンは、

Athens-SR2である。 |

| Type | GroupId | ArtifactId | Version | Spring IO platform | Remarks |

|---|---|---|---|---|---|

Spring |

org.springframework |

spring-aop |

4.3.5.RELEASE |

* |

|

Spring |

org.springframework |

spring-beans |

4.3.5.RELEASE |

* |

|

Spring |

org.springframework |

spring-context |

4.3.5.RELEASE |

* |

|

Spring |

org.springframework |

spring-expression |

4.3.5.RELEASE |

* |

|

Spring |

org.springframework |

spring-core |

4.3.5.RELEASE |

* |

|

Spring |

org.springframework |

spring-tx |

4.3.5.RELEASE |

* |

|

Spring |

org.springframework |

spring-jdbc |

4.3.5.RELEASE |

* |

|

Spring Batch |

org.springframework.batch |

spring-batch-core |

3.0.7.RELEASE |

* |

|

Spring Batch |

org.springframework.batch |

spring-batch-infrastructure |

3.0.7.RELEASE |

* |

|

Spring Retry |

org.springframework.retry |

spring-retry |

1.1.5.RELEASE |

* |

|

Java Batch |

javax.batch |

javax.batch-api |

1.0.1 |

* |

|

Java Batch |

com.ibm.jbatch |

com.ibm.jbatch-tck-spi |

1.0 |

* |

|

MyBatis3 |

org.mybatis |

mybatis |

3.4.2 |

||

MyBatis3 |

org.mybatis |

mybatis-spring |

1.3.1 |

||

MyBatis3 |

org.mybatis |

mybatis-typehandlers-jsr310 |

1.0.2 |

||

DI |

javax.inject |

javax.inject |

1 |

* |

|

ログ出力 |

ch.qos.logback |

logback-classic |

1.1.8 |

* |

|

ログ出力 |

ch.qos.logback |

logback-core |

1.1.8 |

* |

*1 |

ログ出力 |

org.slf4j |

jcl-over-slf4j |

1.7.22 |

* |

|

ログ出力 |

org.slf4j |

slf4j-api |

1.7.22 |

* |

|

入力チェック |

javax.validation |

validation-api |

1.1.0.Final |

* |

|

入力チェック |

org.hibernate |

hibernate-validator |

5.2.4.Final |

* |

|

入力チェック |

org.jboss.logging |

jboss-logging |

3.3.0.Final |

* |

*1 |

入力チェック |

com.fasterxml |

classmate |

1.3.3 |

* |

*1 |

コネクションプール |

org.apache.commons |

commons-dbcp2 |

2.1.1 |

* |

|

コネクションプール |

org.apache.commons |

commons-pool2 |

2.4.2 |

* |

|

EL式 |

org.glassfish |

javax.el |

3.0.0 |

* |

|

インメモリデータベース |

com.h2database |

h2 |

1.4.193 |

* |

|

XML |

com.thoughtworks.xstream |

xstream |

1.4.9 |

* |

*1 |

XML |

xmlpull |

xmlpull |

1.1.3.1 |

*1 |

|

XML |

xpp |

xpp3_min |

1.1.4c |

*1 |

|

XML |

xpp |

xpp3_min |

1.1.4c |

*1 |

|

JSON |

org.codehaus.jettison |

jettison |

1.2 |

* |

*1 |

-

Spring IO platformでサポートしているライブラリが個別に依存しているライブラリ

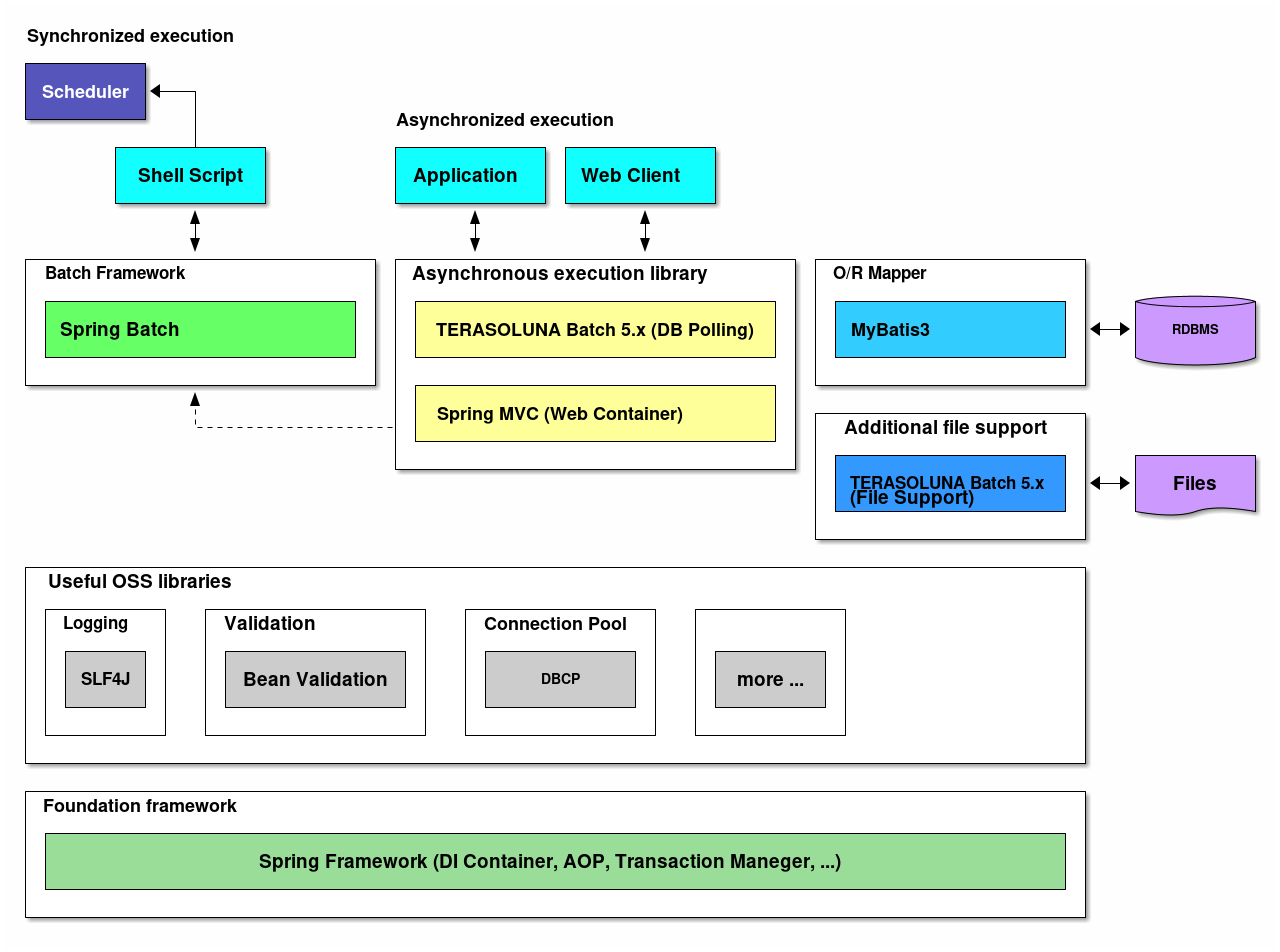

2.2.3. TERASOLUNA Batch Framework for Java (5.x)の構成要素

TERASOLUNA Batch Framework for Java (5.x)のSoftware Framework構成要素について説明する。

以下に、各要素の概要を示す。

- 基盤フレームワーク

-

フレームワークの基盤として、Spring Frameworkを利用する。DIコンテナをはじめ各種機能を活用する。

- バッチフレームワーク

-

バッチフレームワークとして、Spring Batchを利用する。

- 非同期実行

-

非同実行を実現する方法として、以下の機能を利用する。

- DBポーリングによる周期起動

-

TERASOLUNA Batch Framework for Java (5.x)が提供するライブラリを利用する。

- Webコンテナ起動

-

Spring MVCを使用して、Spring Batchと連携をする。

- O/R Mapper

-

MyBatisを利用し、Spring Frameworkとの連携ライブラリとして、MyBatis-Springを使用する。

- ファイルアクセス

-

Spring Batchから提供されている機能 に加えて、補助機能をTERASOLUNA Batch Framework for Java (5.x)がする。

- ロギング

-

ロガーはAPIにSLF4J、実装にLogbackを利用する。

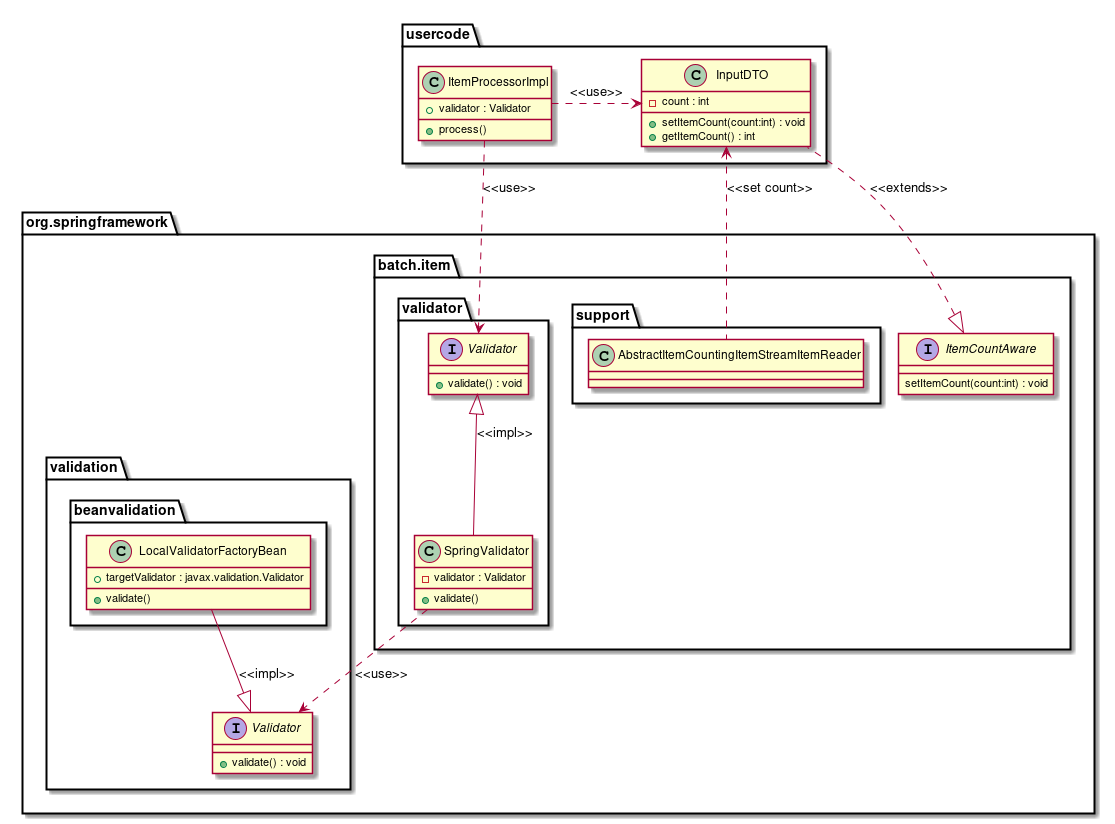

- バリデーション

-

- 単項目チェック

-

単項目チェックにはBean Validationを利用し、実装はHibernate Validatorを使用する。

- 相関チェック

-

相関チェックにはBean Validation、もしくはSpring Validationを利用する。

- コネクションプール

-

コネクションプールには、DBCPを利用する。

2.3. Spring Batchのアーキテクチャ

2.3.1. Overview

TERASOLUNA Server Framework for Java (5.x)の基盤となる、Spring Batchのアーキテクチャについて説明をする。

2.3.1.1. Spring Batchとは

Spring Batchは、その名のとおりバッチアプリケーションフレームワークである。 SpringがもつDIコンテナやAOP、トランザクション管理機能をベースとして以下の機能を提供している。

- 処理の流れを定型化する機能

-

- タスクレットモデル

-

- シンプルな処理

-

自由に処理を記述する方式である。SQLを1回発行するだけ、コマンドを発行するだけ、といった簡素なケースや 複数のデータベースやファイルにアクセスしながら処理するような複雑で定型化しにくいケースで用いる。

- チャンクモデル

-

- 大量データを効率よく処理

-

一定件数のデータごとにまとめて入力/加工/出力する方式。データの入力/加工/出力といった処理の流れを定型化し、 一部を実装するだけでジョブが実装できる。

- 様々な起動方法

-

コマンドライン実行、Servlet上で実行、その他のさまざまな契機での実行を実現する。

- 様々なデータ形式の入出力

-

ファイル、データベース、メッセージキューをはじめとするさまざまなデータリソースとの入出力を簡単に行う。

- 処理の効率化

-

多重実行、並列実行、条件分岐を設定ベースで行う。

- ジョブの管理

-

実行状況の永続化、データ件数を基準にしたリスタートなどを可能にする。

2.3.1.2. Hello, Spring Batch!

Spring Batchのアーキテクチャを理解する上で、未だSpring Batchに触れたことがない場合は、 以下の公式ドキュメントを一読するとよい。 Spring Batchを用いた簡単なアプリケーションの作成を通して、イメージを掴んでほしい。

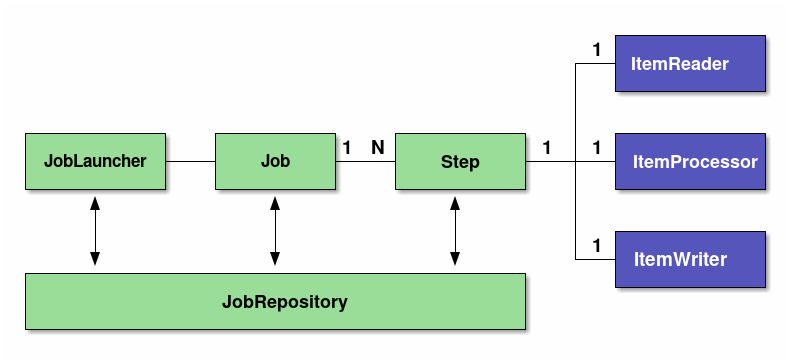

2.3.1.3. Spring Batchの基本構造

Spring Batchの基本的な構造を説明する。

Spring Batchはバッチ処理の構造を定義している。この構造を理解してから開発を行うことを推奨する。

| 構成要素 | 役割 |

|---|---|

Job |

Spring Batchにおけるバッチアプリケーションの一連の処理をまとめた1実行単位。 |

Step |

Jobを構成する処理の単位。1つのJobに1~N個のStepをもたせることが可能。 |

JobLauncher |

Jobを起動するためのインターフェース。 |

ItemReader |

チャンクモデルを実装する際に、データの入力/加工/出力の3つに分割するためのインターフェース。 タスクレットモデルでは、ItemReader/ItemProcessor/ItemWriterが、1つのTaksletインターフェース実装に置き換わる。Tasklet内に入出力、入力チェック、ビジネスロジックのすべてを実装する必要がある。 |

JobRepository |

JobやStepの状況を管理する機構。これらの管理情報は、Spring Batchが規定するテーブルスキーマを元にデータベース上に永続化される。 |

2.3.2. Architecture

OverviewではSpring Batchの基本構造については簡単に説明した。

これを踏まえて、以下の点について説明をする。

最後に、Spring Batchを利用したバッチアプリケーションの性能チューニングポイントについて説明をする。

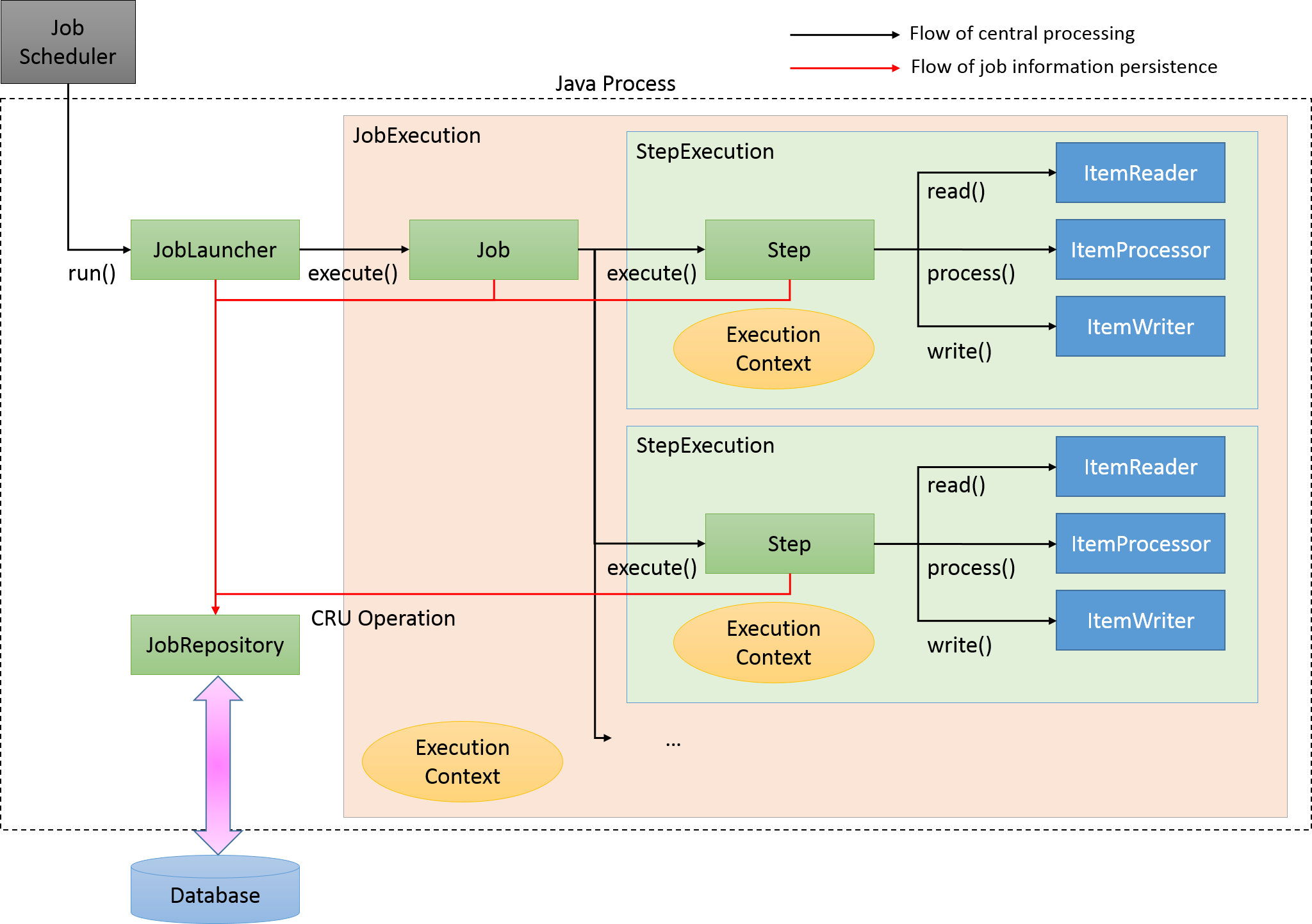

2.3.2.1. 処理全体の流れ

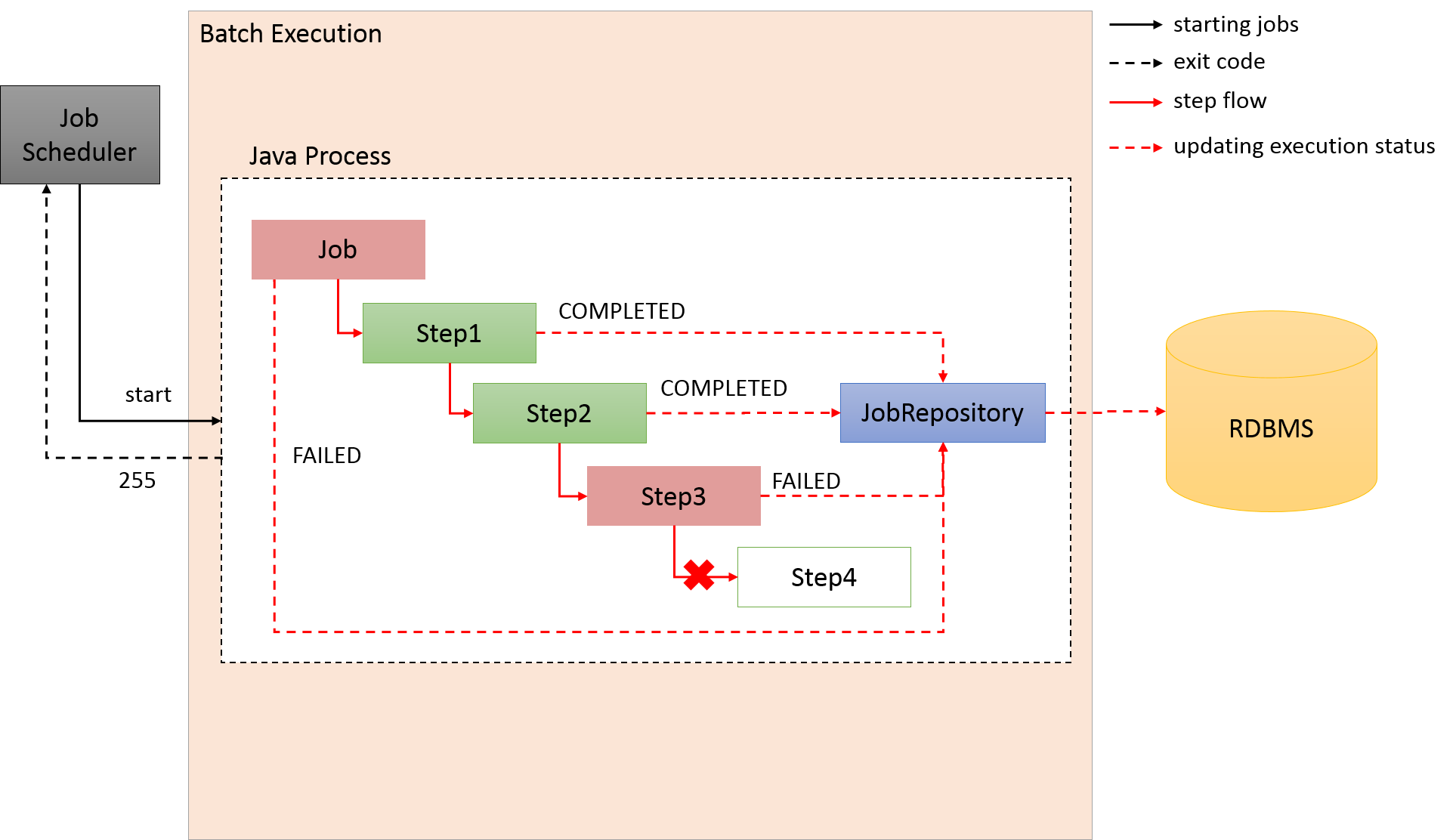

Spring Batchの主な構成要素と処理全体の流れについて説明をする。 また、ジョブの実行状況などのメタデータがどのように管理されているかについても説明する。

Spring Batchの主な構成要素と処理全体の流れ(チャンクモデル)を下図に示す。

中心的な処理の流れ(黒線)とジョブ情報を永続化する流れ(赤線)について説明する。

-

ジョブスケジューラからJobLauncherが起動される。

-

JobLauncherからJobを実行する。

-

JobからStepを実行する。

-

StepはItemReaderによって入力データを取得する。

-

StepはItemProcessorによって入力データを加工する。

-

StepはItemWriterによって加工されたデータを出力する

-

JobLauncherはJobRepositoryを介してDatabaseにJobInstanceを登録する。

-

JobLauncherはJobRepositoryを介してDatabaseにジョブが実行開始したことを登録する。

-

JobStepはJobRepositoryを介してDatabaseに入出力件数や状態など各種情報を更新する。

-

JobLauncherはJobRepositoryを介してDatabaseにジョブが実行終了したことを登録する。

新たに構成要素と永続化に焦点をあてたJobRepositoryについての説明を以下に示す。

| 構成要素 | 役割 |

|---|---|

JobInstance |

Spring BatchはJobの「論理的」な実行を示す。JobInstanceをJob名と引数によって識別している。

言い換えると、Job名と引数が同一である実行は、同一JobInstanceの実行と認識し、前回起動時の続きとしてJobを実行する。 |

JobExecution |

JobExecutionはJobの「物理的」な実行を示す。JobInstance とは異なり、同一のJobを再実行する場

合も別のJobExecutionとなる。結果、JobInstanceとJobExecutionは1対多の関係になる。 |

StepExecution |

StepExecutionはStep の「物理的」な実行を示す。JobExecutionとStepExecutionは1対多の関係になる。 |

JobRepository |

JobExecutionやStepExecutionなどのバッチアプリケーション実行結果や状態を管理するためのデータを管理、永続化する機能を提供する。 |

Spring Batchが重厚にメタデータの管理を行っている理由は、再実行を実現するためである。 バッチ処理を再実行可能にするには、前回実行時のスナップショットを残しておく必要があり、メタデータやJobRepositoryはそのための基盤となっている。

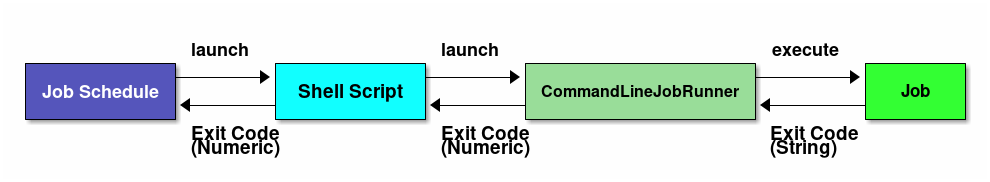

2.3.2.2. Jobの起動

Jobをどのように起動するかについて説明する。

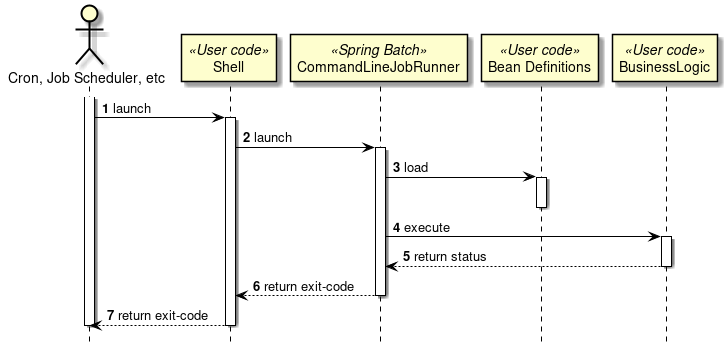

Javaプロセス起動直後にバッチ処理を開始し、バッチ処理が完了後にJavaプロセスを終了するケースを考える。 下図にJavaプロセス起動からバッチ処理を開始までについて処理の流れを示す。

Javaプロセス起動と同時に、Spring Batch上で定義されたJobを開始するためには、Javaを起動するシェルスクリプトを記述するのが一般的である。 Spring Batchが提供するCommandLineJobRunnerを使用すると、ユーザが定義したSpring Batch上のJobを簡単に起動することができる。

CommandLineJobRunnerを使用したジョブの起動コマンドは以下のとおりである。

java -cp ${CLASSPATH} org.springframework.batch.core.launch.support.CommandLineJobRunner <jobPath> <jobName> <JobArgumentName1>=<value1> <JobArgumentName2>=<value2> ...CommandLineJobRunnerは起動するJob名だけでなく、引数(ジョブパラメータ)を渡すことも可能である。

引数は前述した例のように、<Job引数名>=<値>の形式で指定する。

すべての引数はCommandLineJobRunnerやJobLauncherが解釈とチェックを行なったうえで、JobExecutionへJobParametersに変換して格納する。

詳細はジョブの起動パラメータを参照のこと。

JobLauncherがJobRepositoryからJob名と引数に合致するJobInstanceをデータベースから取得する。

-

該当するJobInstanceが存在しない場合は、JobInstanceを新規登録する。

-

該当するJobInstanceが存在した場合は、紐付いているJobExecutionを復元する。

-

Spring Batchでは日次実行など繰り返して起動する可能性のあるJobに対しては、JobInstanceがユニークにするためだけの引数を追加する方法がとられている。 たとえば、システム時刻であったり、乱数を引数に追加する方法が挙げられる。

本ガイドラインで推奨している方法についてはパラメータ変換クラスについてを参照。

-

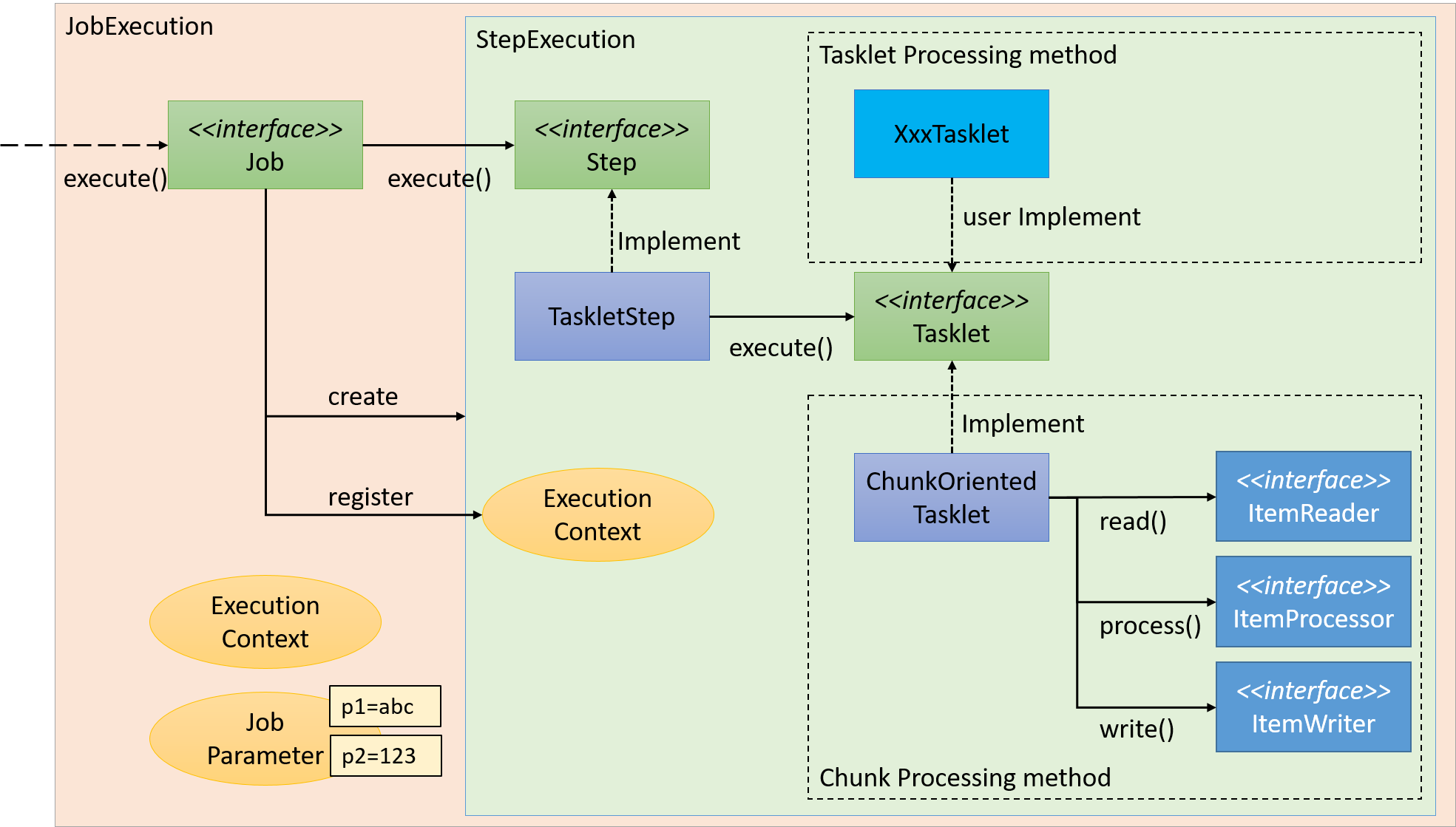

2.3.2.3. ビジネスロジックの実行

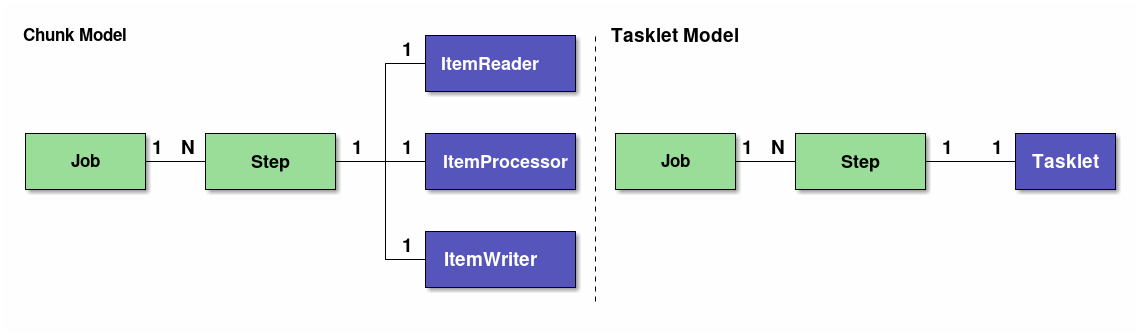

Spring Batchでは、JobをStepと呼ぶさらに細かい単位に分割する。 Jobが起動すると、Jobは自身に登録されているStepを起動し、StepExecutionを生成する。 Stepはあくまで処理を分割するための枠組みであり、ビジネスロジックの実行はStepから呼び出されるTaskletに任されている。

StepからTaskletへの流れを以下に示す。

Taskletの実装方法には「チャンクモデル」と「タスクレットモデル」の2つの方式がある。 概要についてはすでに説明しているため、ここではその構造について説明する。

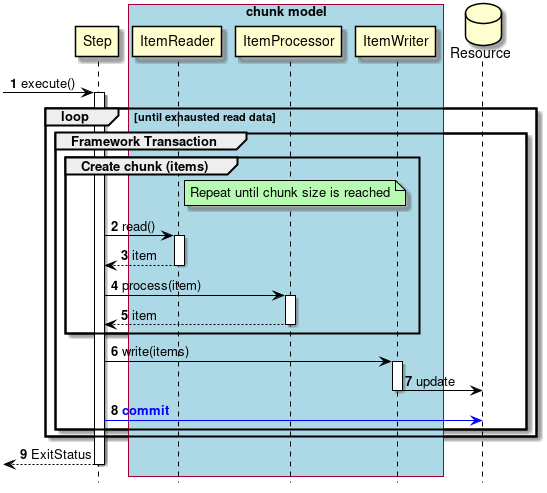

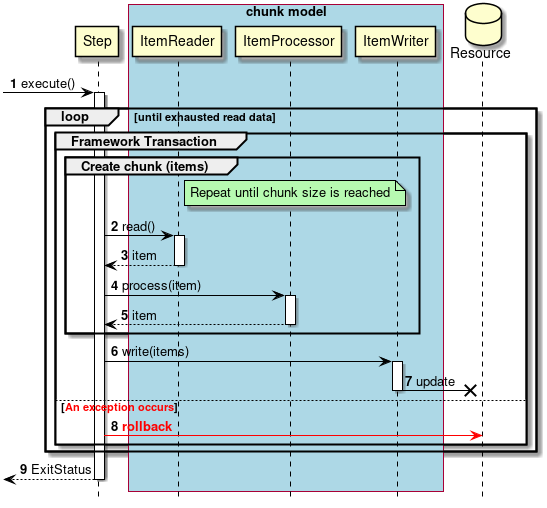

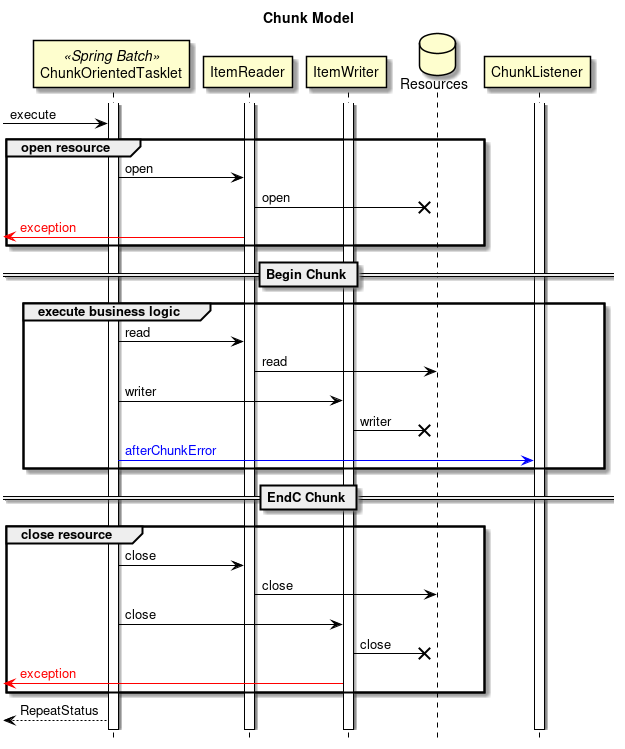

2.3.2.3.1. チャンクモデル

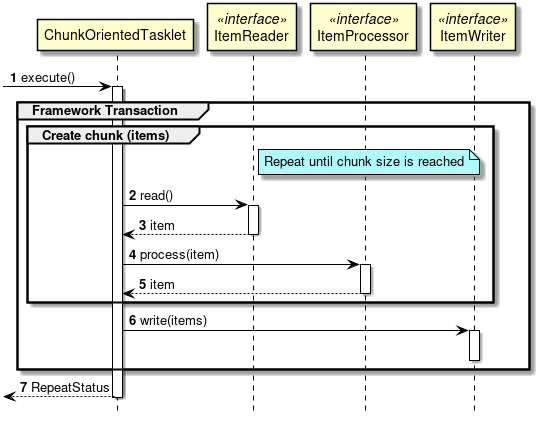

前述したようにチャンクモデルとは、処理対象となるデータを1件ずつ処理するのではなく、一定数の塊(チャンク)を単位として処理を行う方式である。 ChunkOrientedTaskletがチャンク処理をサポートしたTaskletの具象クラスとなる。 このクラスがもつcommit-intervalという設定値により、チャンクに含めるデータの最大件数(以降、「チャンク数」と呼ぶ)を調整することができる。 ItemReader、ItemProcessor、ItemWriterは、いずれもチャンク処理を前提としたインターフェースとなっている。

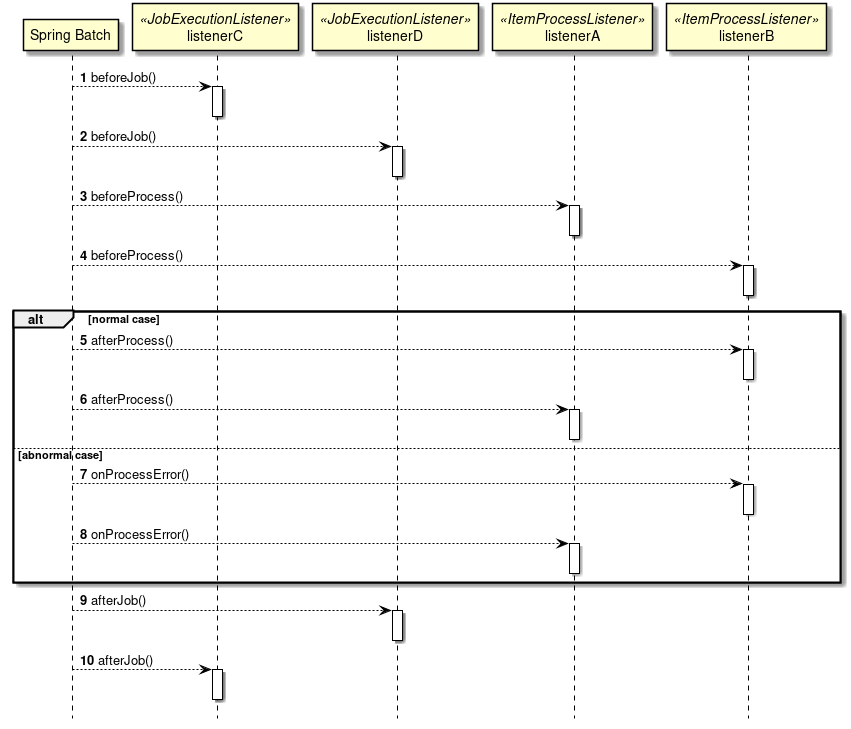

次に、ChunkOrientedTasklet がどのようにItemReader、ItemProcessor、ItemWriterを呼び出しているかを説明する。

ChunkOrientedTaskletが1つのチャンクを処理するシーケンス図を以下に示す。

ChunkOrientedTaskletは、チャンク数分だけItemReaderおよびItemProcessor、すなわちデータの読み込みと加工を繰り返し実行する。 チャンク数分のデータすべての読み込みが完了してから、ItemWriterのデータ書き込み処理が1回だけ呼び出され、チャンクに含まれるすべての加工済みデータが渡される。 データの更新処理がチャンクに対して1回呼び出されるように設計されているのは、JDBCのaddBatch、executeBatchのようにI/Oをまとめやすくするためである。

次に、チャンク処理において実際の処理を担うItemReader、ItemProcessor、ItemWriterについて紹介する。 各インターフェースともユーザが独自に実装を行うことが想定されているが、Spring Batchが提供する汎用的な具象クラスでまかなうことができる場合がある。

特にItemProcessorはビジネスロジックそのものが記述されることが多いため、Spring Batchからは具象クラスがあまり提供されていない。 ビジネスロジックを記述する場合はItemProcessorインターフェースを実装する。 ItemProcessorはタイプセーフなプログラミングが可能になるよう、入出力で使用するオブジェクトの型をそれぞれジェネリクスに指定できるようになっている。

以下に簡単なItemProcessorの実装例を示す。

public class MyItemProcessor implements

ItemProcessor<MyInputObject, MyOutputObject> { // (1)

@Override

public MyOutputObject process(MyInputObject item) throws Exception { // (2)

MyOutputObject processedObject = new MyOutputObject(); // (3)

// Coding business logic for item of input data

return processedObject; // (4)

}

}| 項番 | 説明 |

|---|---|

(1) |

入出力で使用するオブジェクトの型をそれぞれジェネリクスに指定したItemProcessorインターフェースを実装する。 |

(2) |

|

(3) |

出力オブジェクトを作成し、入力データのitemに対して処理したビジネスロジックの結果を格納する。 |

(4) |

出力オブジェクトを返却する。 |

ItemReaderやItemWriterは様々な具象クラスがSpring Batchから提供されており、それらを利用することで十分な場合が多い。 しかし、特殊な形式のファイルを入出力したりする場合は、独自のItemReaderやItemWriterを実装した具象クラスを作成し使用することができる。

実際のアプリケーション開発時におけるビジネスロジックの実装に関しては、アプリケーション開発の流れを参照。

最後にSpring Batchが提供するItemReader、ItemProcessor、ItemWriterの代表的な具象クラスを示す。

| インターフェース | 具象クラス名 | 概要 |

|---|---|---|

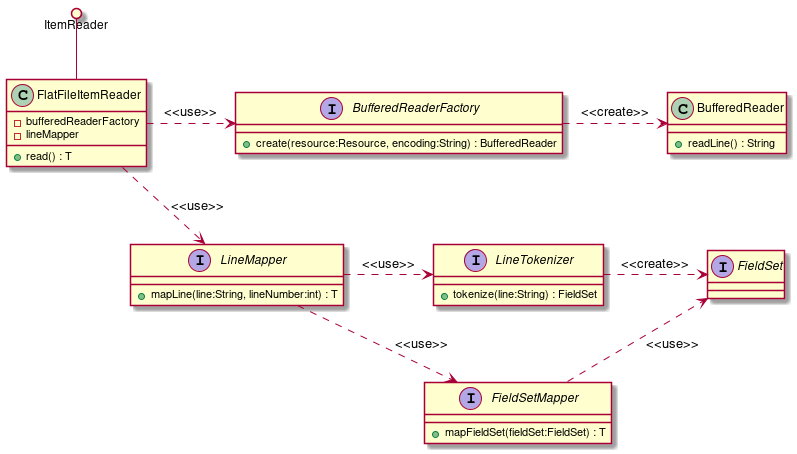

ItemReader |

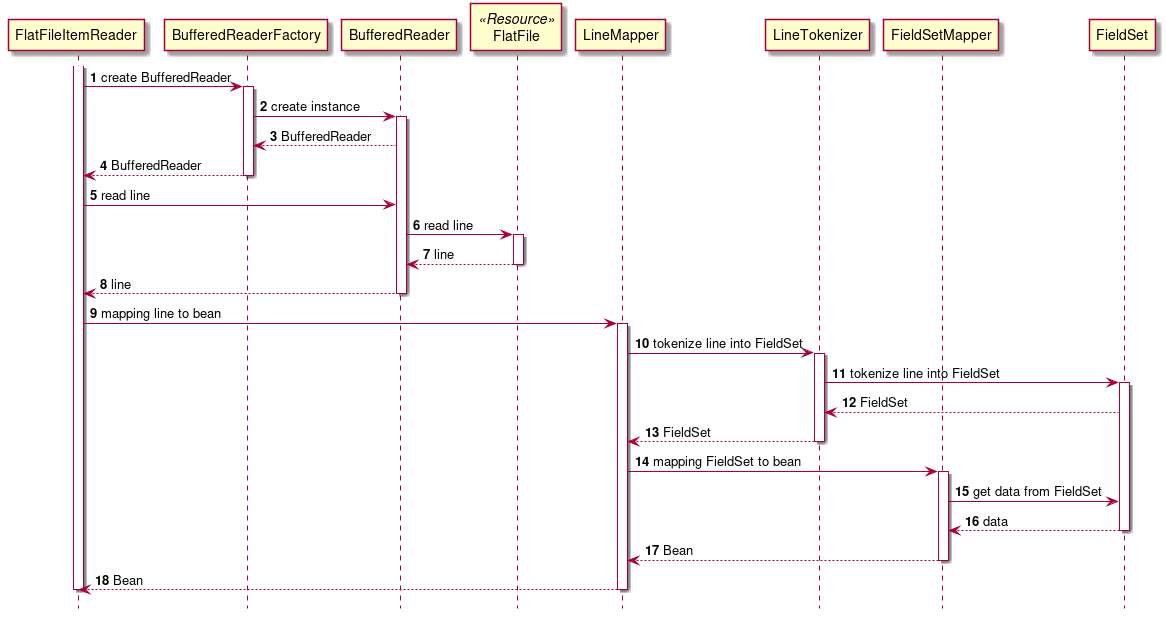

FlatFileItemReader |

CSVファイルなどの、フラットファイル(非構造的なファイル)の読み込みを行う。Resourceオブジェクトをインプットとし、区切り文字やオブジェクトへのマッピングルールをカスタマイズすることができる。 |

StaxEventItemReader |

XMLファイルの読み込みを行う。名前のとおり、StAXをベースとしたXMLファイルの読み込みを行う実装となっている。 |

|

JdbcPagingItemReader |

JDBCを使用してSQLを実行し、データベース上のレコードを読み込む。データベース上にある大量のデータを処理する場合は、全件をメモリ上に読み込むことを避け、一度の処理に必要なデータのみの読み込み、破棄を繰り返す必要がある。 |

|

MyBatisCursorItemReader |

MyBatisと連携してデータベース上のレコードを読み込む。MyBatisが提供しているSpring連携ライブラリMyBatis-Springから提供されている。PagingとCursorの違いについては、MyBatisを利用して実現していること以外はJdbcXXXItemReaderと同様。 |

|

JmsItemReader |

JMSやAMQPからメッセージを受信し、その中に含まれるデータの読み込みを行う。 |

|

ItemProcessor |

PassThroughItemProcessor |

何も行なわない。入力データの加工や修正が不要な場合に使用する。 |

ValidatingItemProcessor |

入力チェックを行う。入力チェックルールの実装には、Spring Batch独自の |

|

CompositeItemProcessor |

同一の入力データに対し、複数のItemProcessorを逐次的に実行する。ValidatingItemProcessorによる入力チェックの後にビジネスロジックを実行したい場合などに有効。 |

|

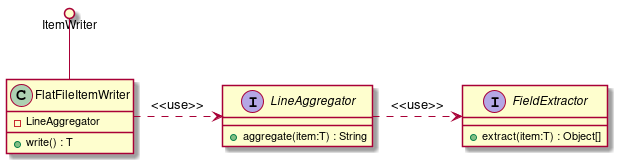

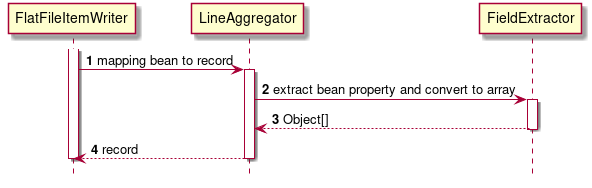

ItemWriter |

FlatFileItemWriter |

処理済みのJavaオブジェクトを、CSVファイルなどのフラットファイルとして書き込みを行う。区切り文字やオブジェクトからファイル行へのマッピングルールをカスタマイズできる。 |

StaxEventItemWriter |

処理済みのJavaオブジェクトをXMLファイルとして書き込みを行う。 |

|

JdbcBatchItemWriter |

JDBCを使用してSQLを実行し、処理済みのJavaオブジェクトをデータベースへ出力する。内部ではJdbcTemplateが使用されている。 |

|

MyBatisBatchItemWriter |

MyBatisと連携して、処理済みのJavaオブジェクトをデータベースへ出力する。MyBatisが提供しているSpring連携ライブラリMyBatis-Springから提供されている。 |

|

JmsItemWriter |

処理済みのJavaオブジェクトを、JMSやAMQPでメッセージを送信する。 |

|

PassThroughItemProcessorの省略

XMLでジョブを定義する場合は、ItemProcessorの設定を省略することができる。 省略した場合、PassThroughItemProcessorと同様に何もせずに入力データをItemWriterへ受け渡すことになる。 ItemProcessorの省略

|

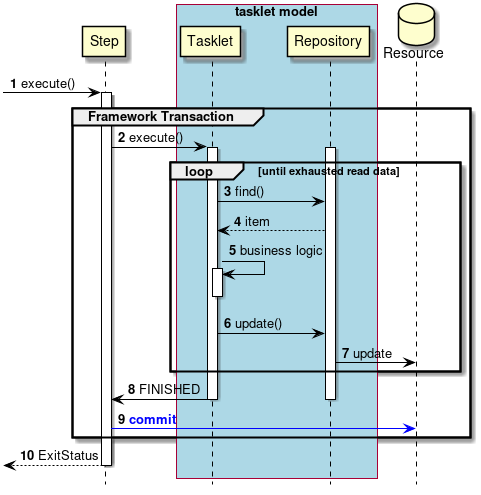

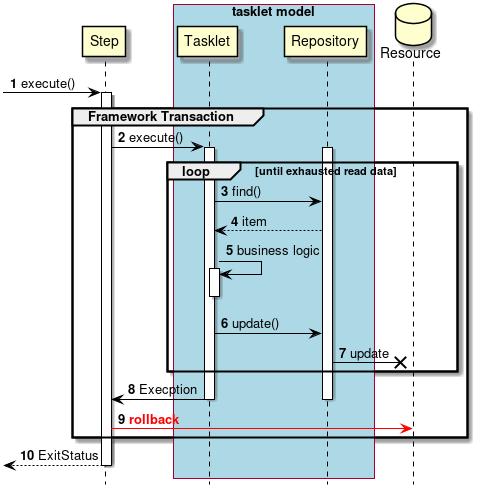

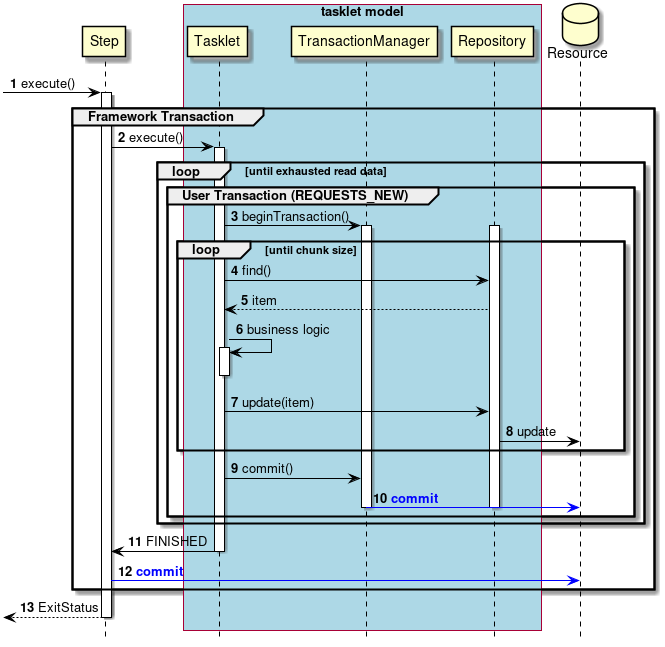

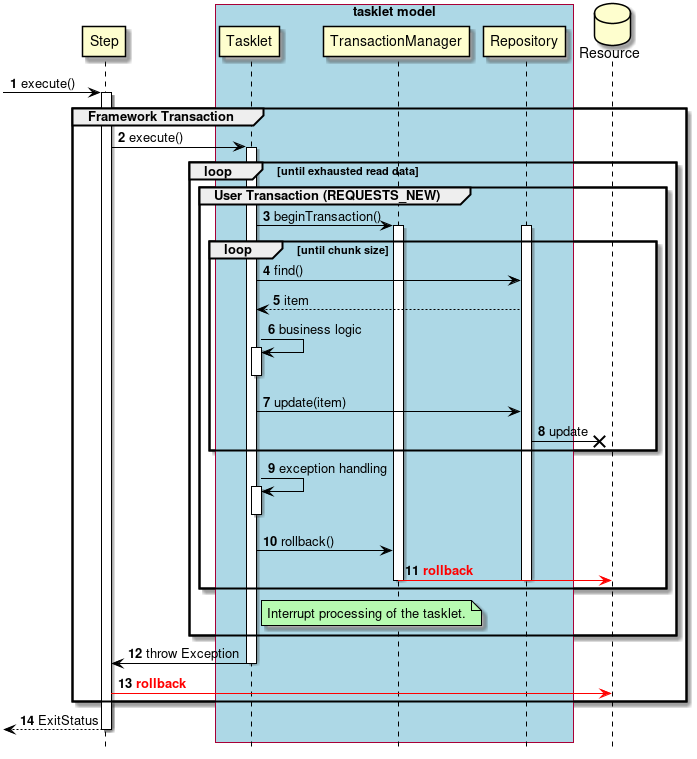

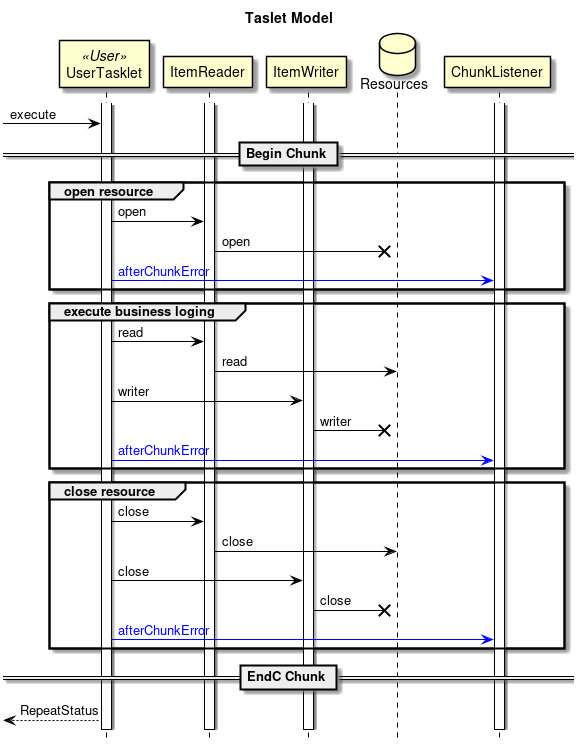

2.3.2.3.2. タスクレットモデル

チャンクモデルは、複数の入力データを1件ずつ読み込み、一連の処理を行うバッチアプリケーションに適した枠組みとなっている。 しかし、時にはチャンク処理の型に当てはまらないような処理を実装することもある。 たとえば、システムコマンドを実行したり、制御用テーブルのレコードを1件だけ更新したいような場合などである。

そのような場合には、チャンク処理によって得られる性能面のメリットが少なく、 設計や実装を困難にするデメリットの方が大きいため、タスクレットモデルを使用するほうが合理的である。

タスクレットモデルを使用する場合は、Spring Batchから提供されているTaskletインターフェースをユーザが実装する必要がある。 また、Spring Batchでは以下の具象クラスが提供されているが、TERASOLUNA Batch 5.xでは以降説明しない。

| クラス名 | 概要 |

|---|---|

SystemCommandTasklet |

非同期にシステムコマンドを実行するためのTasklet。commandプロパティに実行したいコマンドを指定する。 |

MethodInvokingTaskletAdapter |

POJOクラスに定義された特定のメソッドを実行するためのTasklet。targetObjectプロパティに対象クラスのBeanを、targetMethodプロパティに実行させたいメソッド名を指定する。 |

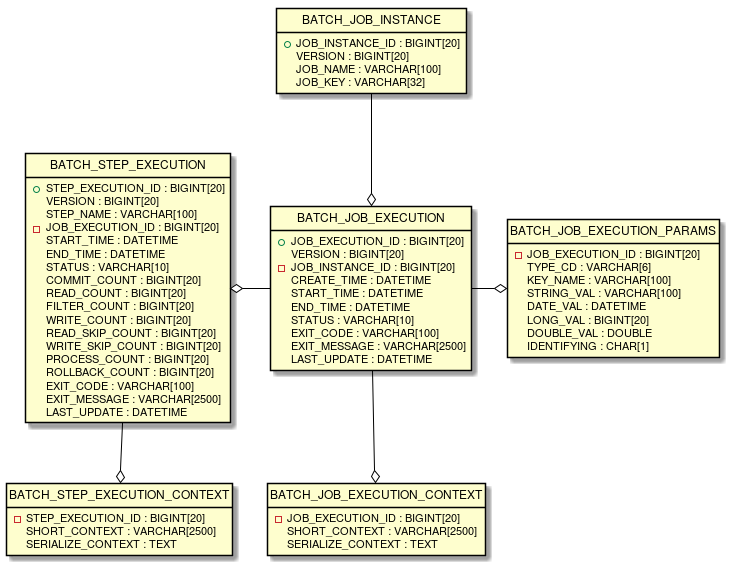

2.3.2.4. JobRepositoryのメタデータスキーマ

JobRepositoryのメタデータスキーマについて説明する。

なお、Spring Batchのリファレンス Appendix B. Meta-Data Schema にて説明されている内容も含めて、全体像を説明する。

Spring Batchメタデータテーブルは、Javaでそれらを表すドメインオブジェクト(Entityオブジェクト)に対応している。

テーブル |

Entityオブジェクト |

概要 |

BATCH_JOB_INSTANCE |

JobInstance |

ジョブ名、およびジョブパラメータをシリアライズした文字列を保持する。 |

BATCH_JOB_EXECUTION |

JobExecution |

ジョブの状態・実行結果を保持する。 |

BATCH_JOB_EXECUTION_PARAMS |

JobExecutionParams |

起動時に与えられたジョブパラメータを保持する。 |

BATCH_JOB_EXECUTION_CONTEXT |

JobExecutionContext |

ジョブ内部のコンテキストを保持する。 |

BATCH_STEP_EXECUTION |

StepExecution |

ステップの状態・実行結果、コミット・ロールバック件数を保持する。 |

BATCH_STEP_EXECUTION_CONTEXT |

StepExecutionContext |

ステップ内部のコンテキストを保持する。 |

JobRepositoryは、各Javaオブジェクトに保存された内容を、テーブルへ正確に格納する責任がある。

6つの全テーブルと相互関係のERDモデルはを以下に示す。

2.3.2.4.1. バージョン

データベーステーブルの多くは、バージョンカラムが含まれてる。 Spring Batchは、データベースへの更新を扱う楽観的ロック戦略を採用しているため、このカラムは重要となる。 このレコードは、バージョンカラムの値がインクリメントされるたびに更新されることを意味している。 JobRepositoryが値の更新時に、バージョン番号が変更されている場合、同時アクセスのエラーが発生したことを示すOptimisticLockingFailureExceptionがスローされる。 別のバッチジョブは異なるマシンで実行されているかもしれないが、それらはすべて同じデータベーステーブルを使用しているため、このチェックが必要となる。

2.3.2.4.2. ID(シーケンス)定義

BATCH_JOB_INSTANCE、BATCH_JOB_EXECUTION、およびBATCH_STEP_EXECUTIONは各_IDで終わる列が含まれている。

これらのフィールドは、それぞれのテーブル用主キーとして機能する。

しかし、それらは、データベースで生成されたキーではなく、むしろ個別のシーケンスで生成される。

データベースにドメインオブジェクトのいずれかを挿入した後、それが与えられたキーは、それらが一意にJavaで識別できるように、実際のオブジェクトに設定する必要なためである。

データベースによってはシーケンスをサポートしていないことがある。この場合、テーブルを各シーケンスの代わりに使用している。

2.3.2.4.3. テーブル定義

各テーブルの項目について説明をする。

BATCH_JOB_INSTANCEテーブルはJobInstanceに関連するすべての情報を保持し、全体的な階層の最上位である。

| カラム名 | 説明 |

|---|---|

JOB_INSTANCE_ID |

インスタンスを識別する一意のIDで主キーである。 |

VERSION |

バージョンを参照。 |

JOB_NAME |

ジョブの名前。 インスタンスを識別するために必要とされるので非nullである。 |

JOB_KEY |

同じジョブを別々のインスタンスとして一意に識別するためのシリアライズ化されたJobParameters。 |

BATCH_JOB_EXECUTIONテーブルはJobExecutionオブジェクトに関連するすべての情報を保持する。 ジョブが実行されるたびに、常に新しいJobExecutionでこの表に新しい行が登録される。

| カラム名 | 説明 |

|---|---|

JOB_EXECUTION_ID |

一意にこのジョブ実行を識別する主キー。 |

VERSION |

バージョンを参照。 |

JOB_INSTANCE_ID |

このジョブ実行が属するインスタンスを示すBATCH_JOB_INSTANCEテーブルからの外部キー。 インスタンスごとに複数の実行が存在する場合がある。 |

CREATE_TIME |

ジョブ実行が作成された時刻。 |

START_TIME |

ジョブ実行が開始された時刻。 |

END_TIME |

ジョブ実行が成功または失敗に関係なく、終了した時刻を表す。 |

STATUS |

ジョブ実行のステータスを表す文字列。BatchStatus列挙オブジェクトが出力する文字列である。 |

EXIT_CODE |

ジョブ実行の終了コードを表す文字列。 CommandLineJobRunnerによる起動の場合、これを数値に変換することができる。 |

EXIT_MESSAGE |

ジョブが終了状態のより詳細な説明を表す文字列。 障害が発生した場合には、可能であればスタックトレースをできるだけ多く含む文字列となる場合がある。 |

LAST_UPDATED |

このレコードのジョブ実行が最後に更新された時刻。 |

BATCH_JOB_EXECUTION_PARAMSテーブルは、JobParametersオブジェクトに関連するすべての情報を保持する。 これはジョブに渡された0以上のキーと値とのペアが含まれ、ジョブが実行されたパラメータを記録する役割を果たす。

| カラム名 | 説明 |

|---|---|

JOB_EXECUTION_ID |

このジョブパラメータが属するジョブ実行を示すBATCH_JOB_EXECUTIONテーブルからの外部キー。 |

TYPE_CD |

String、date、long、またはdoubleのいずれかのデータ型であることを示す文字列。 |

KEY_NAME |

パラメータキー。 |

STRING_VAL |

データ型が文字列である場合のパラメータ値。 |

DATE_VAL |

データ型が日時である場合のパラメータ値。 |

LONG_VAL |

データ型が整数値である場合のパラメータ値。 |

DOUBLE_VAL |

データ型が実数である場合のパラメータ値。 |

IDENTIFYING |

パラメータがジョブインスタンスが一意であることを識別するための値であることを示すフラグ。 |

|

ジョブパラメータの制約について

|

BATCH_JOB_EXECUTION_CONTEXTテーブルは、JobのExecutionContextに関連するすべての情報は保持する。 特定のジョブ実行に必要とされるジョブレベルのデータがすべて含まれている。 このデータは、ジョブが失敗した後で処理を再処理する際に取得しなければならない状態を表し、失敗したジョブが「処理を中断したところから始める」ことを可能にする。

| カラム名 | 説明 |

|---|---|

JOB_EXECUTION_ID |

このJobのExecutionContextが属するジョブ実行を示すBATCH_JOB_EXECUTIONテーブルからの外部キー。 |

SHORT_CONTEXT |

SERIALIZED_CONTEXTの文字列表現。 |

SERIALIZED_CONTEXT |

シリアライズされたコンテキスト全体。 |

BATCH_STEP_EXECUTIONテーブルは、StepExecutionオブジェクトに関連するすべての情報を保持する。 このテーブルには、BATCH_JOB_EXECUTIONテーブルと多くの点で非常に類似しており、各JobExecutionが作られるごとに常にStepごとに少なくとも1つのエントリがある。

| カラム名 | 説明 |

|---|---|

STEP_EXECUTION_ID |

一意にこのステップ実行を識別する主キー。 |

VERSION |

バージョンを参照。 |

STEP_NAME |

ステップの名前。 |

JOB_EXECUTION_ID |

このStepExecutionが属するJobExecutionを示すBATCH_JOB_EXECUTIONテーブルからの外部キー。 |

START_TIME |

ステップ実行が開始された時刻。 |

END_TIME |

ステップ実行が成功または失敗に関係なく、終了した時刻を表す。 |

STATUS |

ステップ実行のステータスを表す文字列。BatchStatus列挙オブジェクトが出力する文字列である。 |

COMMIT_COUNT |

トランザクションをコミットしている回数。 |

READ_COUNT |

ItemReaderで読み込んだデータ件数。 |

FILTER_COUNT |

ItemProcessorでフィルタリングしたデータ件数。 |

WRITE_COUNT |

ItemWriterで書き込んだデータ件数。 |

READ_SKIP_COUNT |

ItemReaderでスキップしたデータ件数。 |

WRITE_SKIP_COUNT |

ItemWriterでスキップしたデータ件数。 |

PROCESS_SKIP_COUNT |

ItemProcessorでスキップしたデータ件数。 |

ROLLBACK_COUNT |

トランザクションをロールバックしている回数。 |

EXIT_CODE |

ステップ実行の終了コードを表す文字列。 CommandLineJobRunnerによる起動の場合、これを数値に変換することができる。 |

EXIT_MESSAGE |

ステップが終了状態のより詳細な説明を表す文字列。 障害が発生した場合には、可能であればスタックトレースをできるだけ多く含む文字列となる場合がある。 |

LAST_UPDATED |

このレコードのステップ実行が最後に更新された時刻。 |

BATCH_STEP_EXECUTION_CONTEXTテーブルは、StepのExecutionContext に関連するすべての情報を保持する。 特定のステップ実行に必要とされるステップレベルのデータがすべて含まれている。 このデータは、ジョブが失敗した後で処理を再処理する際に取得しなければならない状態を表し、失敗したジョブが「処理を中断したところから始める」ことを可能にする。

| カラム名 | 説明 |

|---|---|

STEP_EXECUTION_ID |

このStepのExecutionContextが属するジョブ実行を示すBATCH_STEP_EXECUTIONテーブルからの外部キー。 |

SHORT_CONTEXT |

SERIALIZED_CONTEXTの文字列表現。 |

SERIALIZED_CONTEXT |

シリアライズされたコンテキスト全体。 |

2.3.2.5. 代表的な性能チューニングポイント

Spring Batchにおける代表的な性能チューニングポイントを説明する。

- チャンクサイズの調整

-

リソースへの出力によるオーバヘッドを抑えるために、チャンクサイズを大きくする。

ただし、チャンクサイズを大きくしすぎるとリソース側の負荷が高くなりかえって性能が低下することがあるので、 適度なサイズになるように調整を行う。 - フェッチサイズの調整

-

リソースからの入力によるオーバヘッドを抑えるために、リソースに対するフェッチサイズ(バッファサイズ)を大きくする。

- ファイル読み込みの効率化

-

BeanWrapperFieldSetMapperを使用すると、Beanのクラスとプロパティ名を順番に指定するだけでレコードをBeanにマッピングしてくれる。 しかし、内部で複雑な処理を行うため時間がかかる。マッピングを行う専用のFieldSetMapperインターフェース実装を用いることで処理時間を短縮できる可能性がある。

ファイル入出力の詳細は、ファイルアクセスを参照。 - 並列処理・多重処理

-

Spring Batchでは、Step実行の並列化、データ分割による多重処理をサポートしている。並列化もしくは多重化を行い、処理を並列走行させることで性能を改善できる。 しかし、並列数および多重数を大きくしすぎるとリソース側の負荷が高くなりかえって性能が低下することがあるので、適度なサイズになるように調整を行う。

並列処理・多重処理の詳細は、並列処理と多重処理を参照。 - 分散処理の検討

-

Spring Batchでは、複数マシンでの分散処理もサポートしている。指針は、並列処理・多重処理と同様である。

分散処理は、基盤設計や運用設計が複雑化するため、本ガイドラインでは説明を行わない。

2.4. TERASOLUNA Batch Framework for Java (5.x)のアーキテクチャ

2.4.1. 概要

TERASOLUNA Batch Framework for Java (5.x)のアーキテクチャ全体像を説明する。

TERASOLUNA Batch Framework for Java (5.x)では、一般的なバッチ処理システムで説明したとおり Spring Batchを中心としたOSSの組み合わせを利用して実現する。

Spring Batchの階層アーキテクチャを含めたTERASOLUNA Batch Framework for Java (5.x)の構成概略図を以下に示す。

- アプリケーション

-

開発者によって書かれたすべてのジョブ定義およびビジネスロジック。

- コア

-

Spring Batch が提供するバッチジョブを起動し、制御するために必要なコア・ランタイム・クラス。

- インフラストラクチャ

-

Spring Batch が提供する開発者およびコアフレームワーク自体が利用する一般的なItemReader/ItemProcessor/ItemWriterの実装。

2.4.2. ジョブの構成要素

ジョブの構成要素を説明するため、ジョブの構成概略図を下記に示す。

この節では、ジョブとステップについて構成すべき粒度の指針も含めて説明をする。

2.4.2.1. ジョブ

ジョブとは、バッチ処理全体をカプセル化するエンティティであり、ステップを格納するためのコンテナである。

1つのジョブは、1つ以上のステップで構成することができる。

ジョブの定義は、XMLによるBean定義ファイルに記述する。 ジョブ定義ファイルには複数のジョブを定義することができるが、ジョブの管理が煩雑になりやすくなる。

従って、TERASOLUNA Batch Framework for Java (5.x)では以下の指針とする。

1ジョブ=1ジョブ定義ファイル

2.4.2.2. ステップ

ステップとは、バッチ処理を制御をるために必要な情報を定義したものである。 ステップにはチャンクモデルとタスクレットモデルを定義することができる。

- チャンクモデル

-

-

ItemReader、ItemProcessor、およびItemWriterで構成される。

-

- タスクレットモデル

-

-

Taskletだけで構成される。

-

バッチ処理で考慮する原則と注意点にあるとおり、 単一のバッチ処理では、可能な限り簡素化し、複雑な論理構造を避ける必要がある。

従って、TERASOLUNA Batch Framework for Java (5.x)では以下の指針とする。

1ステップ=1バッチ処理=1ビジネスロジック

|

チャンクモデルでのビジネスロジック分割

1つのビジネスロジックが複雑で規模が大きくなる場合、ビジネスロジックを分割することがある。 概略図を見るとわかるとおり、1つのステップには1つのItemProcessorしか設定できないため、ビジネスロジックの分割ができないように思える。 しかし、CompositeItemProcssorという複数のItemProcessorをまとめるItemProcessorがあり、 この実装を使うことでビジネスロジックを分割して実行することができる。 |

2.4.3. ステップの実装方式

2.4.3.1. チャンクモデル

チャンクモデルの定義と使用目的を説明する。

- 定義

-

ItemReader、ItemProcessorおよびItemWriter実装とチャンク数をChunkOrientedTaskletに設定する。それぞれの役割を説明する。

-

ChunkOrientedTasklet・・・ItemReader/ItemProcessorを呼び出し、チャンクを作成する。作成したチャンクをItemWriterへ渡す。

-

ItemReader・・・入力データを読み込む。

-

ItemProcessor・・・読み込んだデータを加工する。

-

ItemWriter・・・加工されたデータをチャンク単位で出力する。

-

-

チャンクモデルの概要は、 チャンクモデル を参照。

<batch:job id="exampleJob">

<batch:step id="exampleStep">

<batch:tasklet>

<batch:chunk reader="reader"

processor="processor"

writer="writer"

commit-interval="100" />

</batch:tasklet>

</batch:step>

</batch:job>- 使用目的

-

一定件数のデータをまとめて処理を行うため、大量データを取り扱う場合に用いられる。

2.4.3.2. タスクレットモデル

タスクレットモデルの定義・使用目的を説明する。

- 定義

-

Tasklet実装だけを設定する。

タスクレットモデルの概要は、 タスクレットモデル を参照。

.タスクレットモデルのジョブ設定例

----

<batch:job id="exampleJob">

<batch:step id="exampleStep">

<batch:tasklet ref="myTasklet">

</batch:step>

</batch:job>

----- 使用目的

-

システムコマンドの実行など、入出力を伴わない処理を実行するために用いられる。

また、一括でデータをコミットしたい場合にも用いられる。

2.4.3.3. チャンクモデルとタスクレットモデルの機能差

チャンクモデルとタスクレットモデルの機能差について説明する。 ここでは、詳細については各機能の節を参照してもらい、ここでは概略のみにとどめる。

| 機能 | チャンクモデル | タスクレットモデル |

|---|---|---|

構成要素 |

ItemReader/ItemProcessor/ItemWriter/ChunkOrientedTaskletで構成される。 |

Taksletのみで構成される。 |

トランザクション |

チャンク単位にトランザクションが発生する。 |

1トランザクションで処理する。 |

推奨する再処理方式 |

リラン、リスタートを利用できる。 |

リランのみ利用することを原則とする。 |

例外ハンドリング |

リスナーを使うことでハンドリング処理が容易になっている。独自実装も可能である。 |

独自実装が必要である。 |

2.4.4. ジョブの起動方式

ジョブの起動方式について説明する。ジョブの起動方式には以下のものがある。

それぞれの起動方式について説明する。

2.4.4.1. 同期実行方式

同期実行方式とは、ジョブを起動してからジョブが終了するまで起動元へ制御が戻らない実行方式である。

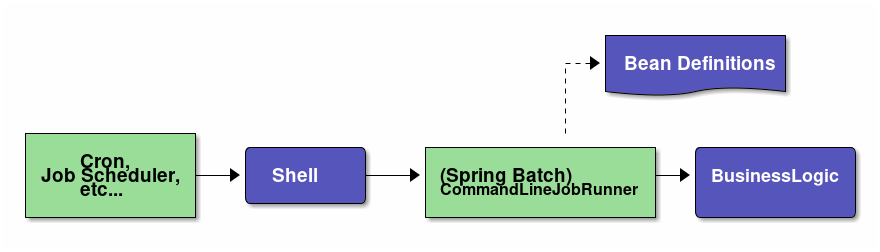

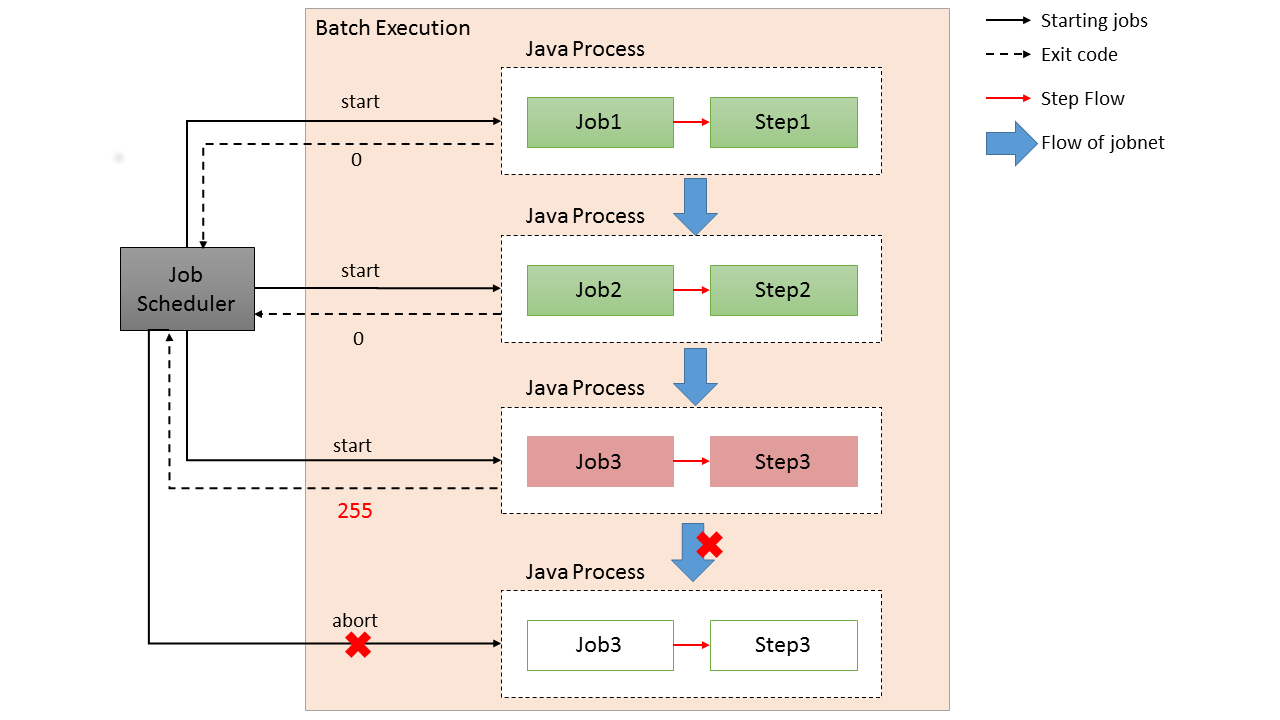

ジョブスケジューラからジョブを起動する概略図を示す。

-

ジョブスケジューラからジョブを起動するためのシェルスクリプトを起動する。

シェルスクリプトから終了コード(数値)が返却するまでジョブスケジューラは待機する。 -

シェルスクリプトからジョブを起動するために

CommandLineJonRunnerを起動する。

CommandLineJonRunnerから終了コード(数値)が返却するまでシェルスクリプトは待機する。 -

CommandLineJonRunnerはジョブを起動する。ジョブは処理終了後に終了コード(文字列)をCommandLineJonRunnerへ返却する。

CommandLineJonRunnerは、ジョブから返却された終了コード(文字列)から終了コード(数値)に変換してシェルスクリプトへ返却する。

2.4.4.2. 非同期実行方式

非同期実行方式とは、起動元とは別の実行基盤(別スレッドなど)でジョブを実行することで、ジョブ起動後すぐに起動元へ制御が戻る方式である。 この方式の場合、ジョブの実行結果はジョブ起動とは別の手段で取得する必要がある。

TERASOLUNA Batch Framework for Java (5.x)では、以下に示す2とおりの方法について説明をする。

|

その他の非同期実行方式

MQなどのメッセージを利用して非同期実行を実現することもできるが、ジョブ実行のポイントは同じであるため、{batch5_guide}では説明は割愛する。 |

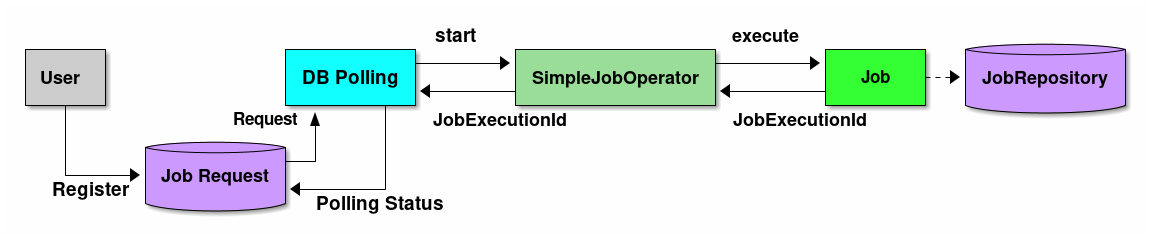

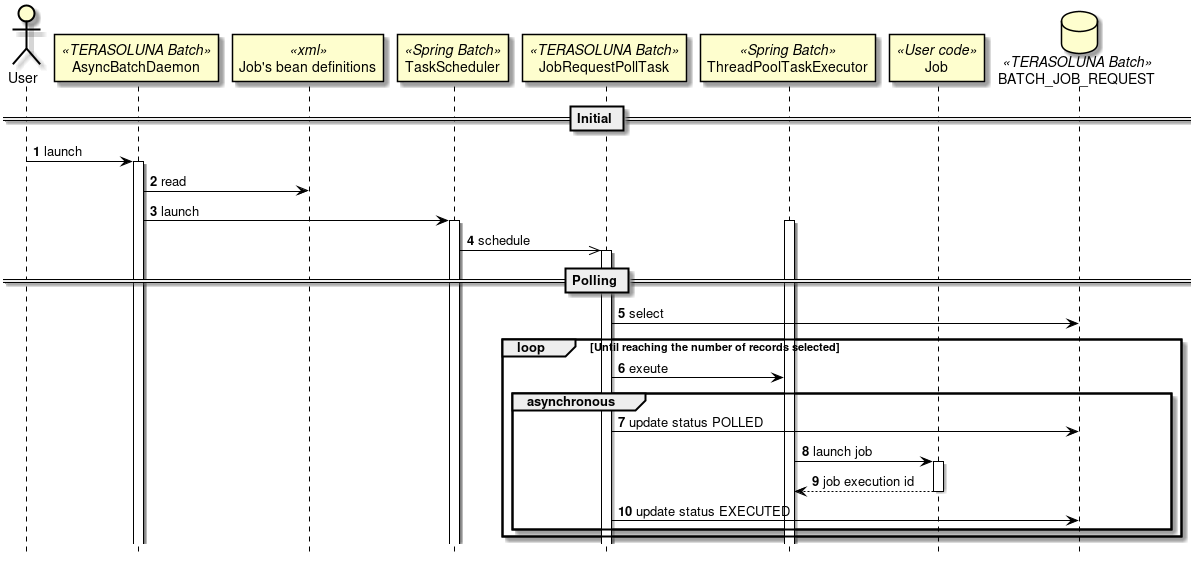

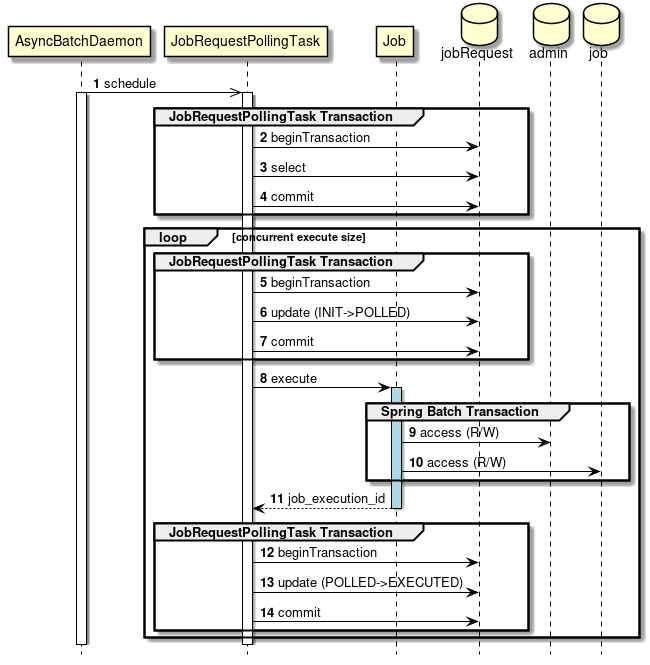

2.4.4.2.1. 非同期実行方式(DBポーリング)

非同期実行(DBポーリング)とは、 ジョブ実行の要求をデータベースに登録し、その要求をポーリングして、ジョブを実行する方式である。

TERASOLUNA Batch Framework for Java (5.x)は、DBポーリング機能を提供している。提供しているDBポーリングによる起動の概略図を示す。

-

ユーザはデータベースへジョブ要求を登録する。

-

DBポーリング機能は、定期的にジョブ要求の登録を監視していて、登録されたことを検知すると該当するジョブを実行する。

-

SimpleJobOperatorからジョブを起動し、ジョブ終了後に

JobExecutionIdを受け取る。 -

JobExecutionIdとは、ジョブ実行を一意に識別するIDであり、このIDを使ってJobRepositoryから実行結果を参照する。

-

ジョブの実行結果は、Spring Batchの仕組みによって、JobRepositoryへ登録される。

-

DBポーリング自体が非同期で実行されている。

-

-

DBポーリング機能は、SimpleJobOperatorから返却されたJobExecutionIdとスタータスを起動したジョブ要求に対して更新を行う。

-

ジョブの処理経過・結果は、JobExecutionIdを利用して別途参照を行う。

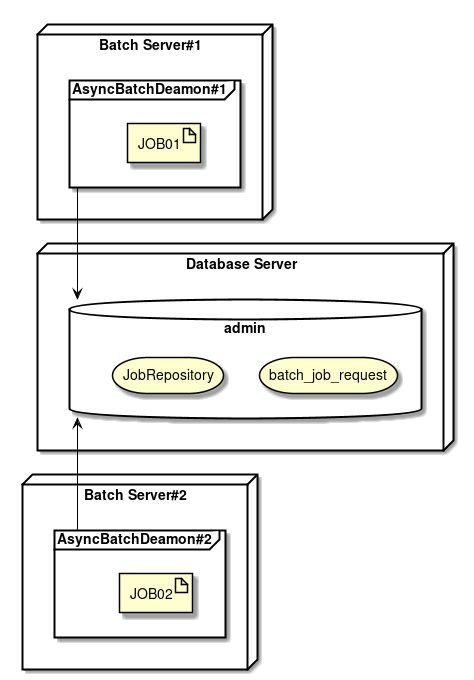

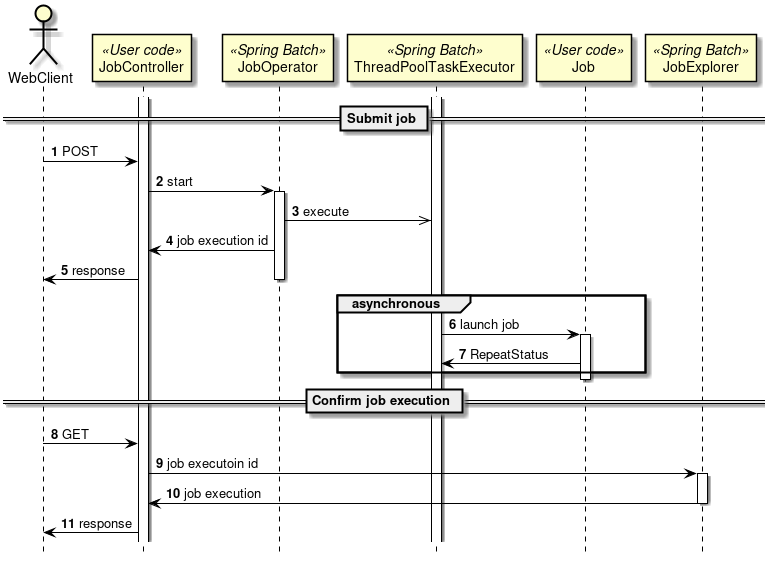

2.4.4.2.2. 非同期実行方式(Webコンテナ)

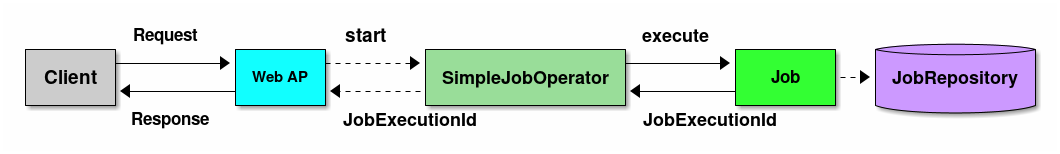

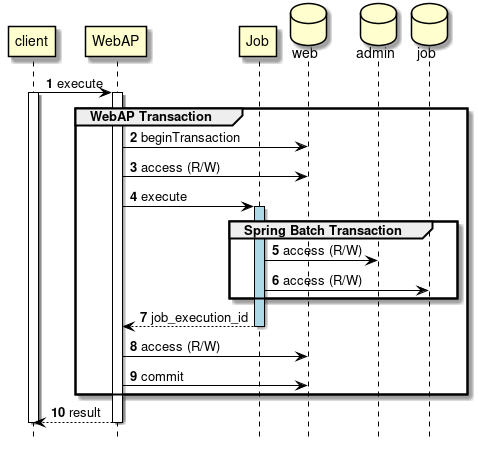

非同期実行(Webコンテナ)とは、 Webコンテナ上のWebアプリケーションへのリクエストを契機にジョブを非同期実行する方式である。 Webアプリケーションは、ジョブの終了を待たずに起動後すぐにレスポンスを返却することができる。

-

クライアントからWebアプリケーションへリクエストを送信する。

-

Webアプリケーションは、リクエストから要求されたジョブを非同期実行する。

-

SimpleJobOperatorからジョブを起動直後に

JobExecutionIdを受け取る。 -

ジョブの実行結果は、Spring Batchの仕組みによって、JobRepositoryへ登録される。

-

-

Webアプリケーションは、ジョブの終了を待たずにクライアントへレスポンスを返信する。

-

ジョブの処理経過・結果は、JobExecutionIdを利用して別途参照を行う。

また、 TERASOLUNA Server Framework for Java (5.x)で構築されるWebアプリケーションと連携することも可能である。

2.4.5. 利用する際の検討ポイント

TERASOLUNA Batch Framework for Java (5.x)を利用する際の検討ポイントを示す。

- ジョブ起動方法

-

- 同期実行方式

-

スケジュールどおりにジョブを起動したり、複数のジョブを組み合わせてバッチ処理行う場合に利用する。

- 非同期実行方式(DBポーリング)

-

ディレード処理、処理時間が短いジョブの連続実行、大量ジョブの集約などに利用する。

- 非同期実行方式(Webコンテナ)

-

DBポーリングと同様だが、起動までの即時性が求められる場合にはこちらを利用する。

- 実装方式

3. アプリケーション開発の流れ

3.1. バッチアプリケーションの開発

バッチアプリケーションの開発について、以下の流れで説明する。

3.1.1. ブランクプロジェクトとは

ブランクプロジェクトとは、Spring BatchやMyBatis3をはじめとする各種設定を予め行った開発プロジェクトの雛形であり、

アプリケーション開発のスタート地点である。

本ガイドラインでは、シングルプロジェクト構成のブランクプロジェクトを提供する。

構成の説明については、プロジェクトの構成を参照のこと。

|

TERASOLUNA Server 5.xとの違い

TERASOLUNA Server 5.xはマルチプロジェクト構成を推奨している。 この理由は主に、以下の様なメリットを享受するためである。

しかし、本ガイドラインではTERASOLUNA Server 5.xと異なりシングルプロジェクト構成としている。 これは、前述の点はバッチアプリケーションの場合においても考慮すべきだが、

シングルプロジェクト構成にすることで1ジョブに関連する資材を近づけることを優先している。 |

3.1.2. プロジェクトの作成

Maven Archetype Pluginのarchetype:generateを使用して、プロジェクトを作成する方法を説明する。

|

作成環境の前提について

以下を前提とし説明する。

|

プロジェクトを作成するディレクトリにて、以下のコマンドを実行する。

C:\xxx> mvn archetype:generate^

-DarchetypeGroupId=org.terasoluna.batch^

-DarchetypeArtifactId=terasoluna-batch-archetype^

-DarchetypeVersion=5.0.0.RELEASE$ mvn archetype:generate \

-DarchetypeGroupId=org.terasoluna.batch \

-DarchetypeArtifactId=terasoluna-batch-archetype \

-DarchetypeVersion=5.0.0.RELEASEその後、利用者の状況に合わせて、以下を対話式に設定する。

-

groupId

-

artifactId

-

version

-

package

以下の値を設定し実行した例を示す。

| 項目名 | 設定例 |

|---|---|

groupId |

com.example.batch |

artifactId |

batch |

version |

1.0.0-SNAPSHOT |

package |

com.example.batch |

[INFO] Scanning for projects...

[INFO]

[INFO] ------------------------------------------------------------------------

[INFO] Building Maven Stub Project (No POM) 1

[INFO] ------------------------------------------------------------------------

[INFO]

[INFO] >>> maven-archetype-plugin:2.4:generate (default-cli) > generate-sources @ standalone-pom >>>

[INFO]

[INFO] <<< maven-archetype-plugin:2.4:generate (default-cli) < generate-sources @ standalone-pom <<<

[INFO]

[INFO] --- maven-archetype-plugin:2.4:generate (default-cli) @ standalone-pom ---

[INFO] Generating project in Interactive mode

(.. omitted)

Define value for property 'groupId': : com.example.batch

Define value for property 'artifactId': : batch

Define value for property 'version': 1.0-SNAPSHOT: : 1.0.0-SNAPSHOT

Define value for property 'package': com.example.batch: :

Confirm properties configuration:

groupId: com.example.batch

artifactId: batch

version: 1.0.0-SNAPSHOT

package: com.example.batch

Y: : y

[INFO] ----------------------------------------------------------------------------

[INFO] Using following parameters for creating project from Archetype: terasoluna-batch-archetype:5.0.0-SNAPSHOT

[INFO] ----------------------------------------------------------------------------

[INFO] Parameter: groupId, Value: com.example.batch

[INFO] Parameter: artifactId, Value: batch

[INFO] Parameter: version, Value: 1.0.0-SNAPSHOT

[INFO] Parameter: package, Value: com.example.batch

[INFO] Parameter: packageInPathFormat, Value: com/example/batch

[INFO] Parameter: package, Value: com.example.batch

[INFO] Parameter: version, Value: 1.0.0-SNAPSHOT

[INFO] Parameter: groupId, Value: com.example.batch

[INFO] Parameter: artifactId, Value: batch

[INFO] project created from Archetype in dir: C:\workspaces\zzz\batch

[INFO] ------------------------------------------------------------------------

[INFO] BUILD SUCCESS

[INFO] ------------------------------------------------------------------------

[INFO] Total time: 02:56 min

[INFO] Finished at: 2017-02-07T17:09:52+09:00

[INFO] Final Memory: 16M/240M

[INFO] ------------------------------------------------------------------------以上により、プロジェクトの作成が完了した。

正しく作成出来たかどうかは、以下の要領で確認できる。

$ mvn clean dependency:copy-dependencies -DoutputDirectory=lib package

$ java -cp 'lib/*:target/*' org.springframework.batch.core.launch.support.CommandLineJobRunner \

META-INF/jobs/job01/job01.xml job01以下の出力が得られれば正しく作成できている。

$ mvn clean dependency:copy-dependencies -DoutputDirectory=lib package

[INFO] Scanning for projects...

[INFO]

[INFO] ------------------------------------------------------------------------

[INFO] Building TERASOLUNA Batch Framework for Java (5.x) Blank Project 1.0.0-SNAPSHOT

[INFO] ------------------------------------------------------------------------

[INFO]

(.. omitted)

[INFO] ------------------------------------------------------------------------

[INFO] BUILD SUCCESS

[INFO] ------------------------------------------------------------------------

[INFO] Total time: 3.618 s

[INFO] Finished at: 2017-02-07T17:32:27+09:00

[INFO] Final Memory: 26M/250M

[INFO] ------------------------------------------------------------------------

$ java -cp 'lib/*;target/*' org.springframework.batch.core.launch.support.CommandLineJobRunner META-INF/jobs/job01/job01.xml job01

[2017/02/07 17:35:26] [main] [o.s.c.s.ClassPathXmlApplicationContext] [INFO ] Refreshing org.springframework.context.support.ClassPathXmlApplicationContext@62043840: startup date [Tue Feb 07 17:35:26 JST 2017]; root of context hierarchy

(.. ommited)

[2017/02/07 17:35:27] [main] [o.s.b.c.l.s.SimpleJobLauncher] [INFO ] Job: [FlowJob: [name=job01]] launched with the following parameters: [{jsr_batch_run_id=1}]

[2017/02/07 17:35:27] [main] [o.s.b.c.j.SimpleStepHandler] [INFO ] Executing step: [job01.step01]

[2017/02/07 17:35:27] [main] [o.s.b.c.l.s.SimpleJobLauncher] [INFO ] Job: [FlowJob: [name=job01]] completed with the following parameters: [{jsr_batch_run_id=1}] and the following status: [COMPLETED]

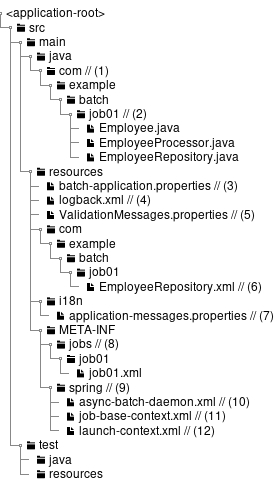

[2017/02/07 17:35:27] [main] [o.s.c.s.ClassPathXmlApplicationContext] [INFO ] Closing org.springframework.context.support.ClassPathXmlApplicationContext@62043840: startup date [Tue Feb 07 17:35:26 JST 2017]; root of context hierarchy3.1.3. プロジェクトの構成

前述までで作成したプロジェクトの構成について説明する。 プロジェクトは、以下の点を考慮した構成となっている。

-

起動方式に依存しないジョブの実装を実現する

-

Spring BatchやMyBatisといった各種設定の手間を省く

-

環境依存の切替を容易にする

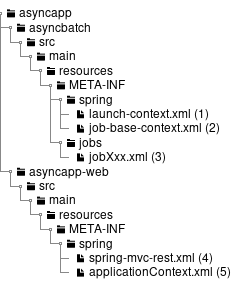

以下に構成を示し、各要素について説明する。

(わかりやすさのため、前述のmvn archetype:generate実行時の出力を元に説明する。)

| 項番 | 説明 |

|---|---|

(1) |

バッチアプリケーション全体の各種クラスを格納するrootパッケージ。 |

(2) |

1ジョブに関する各種クラスを格納するパッケージ。 初期状態を参考にユーザにて自由にカスタムしてよいが、 ジョブ固有の資材を判断しやすくすることに配慮してほしい。 |

(3) |

バッチアプリケーション全体に関わる設定ファイル。 |

(4) |

Logback(ログ出力)の設定ファイル。 |

(5) |

BeanValidationを用いた入力チェックにて、エラーとなった際に表示するメッセージを定義する設定ファイル。 |

(6) |

MyBatis3のMapperインターフェースの対となるMapper XMLファイル。 |

(7) |

主にログ出力時に用いるメッセージを定義するプロパティファイル。 |

(8) |

ジョブ固有のBean定義ファイルを格納するディレクトリ。 |

(9) |

バッチアプリケーション全体に関わるBean定義ファイルを格納するディレクトリ。 |

(10) |

非同期実行(DBポーリング)機能に関連する設定を記述したBean定義ファイル。 |

(11) |

ジョブ固有のBean定義ファイルにてimportすることで、各種設定を削減するためのBean定義ファイル。 |

(12) |

Spring Batchの挙動や、ジョブ共通の設定に対するBean定義ファイル。 |

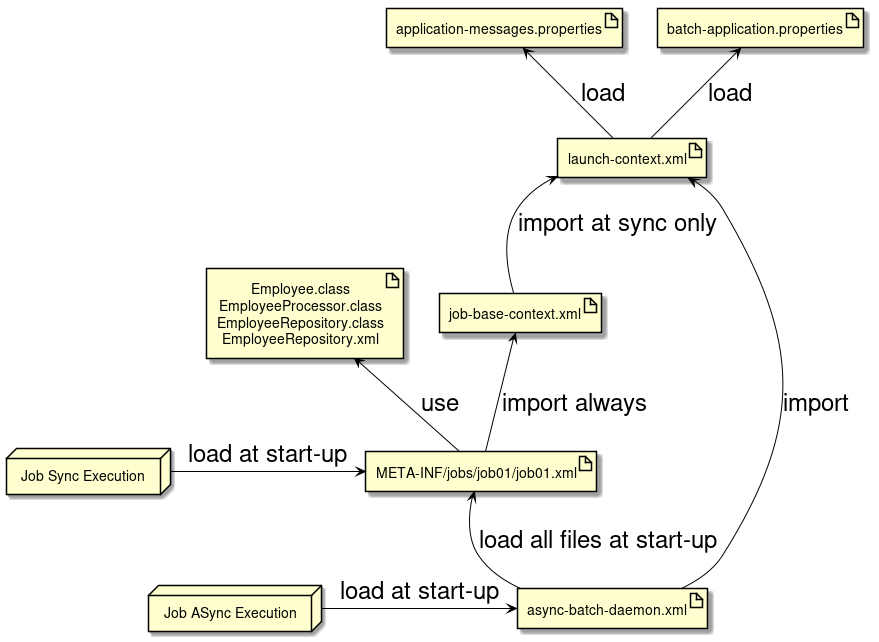

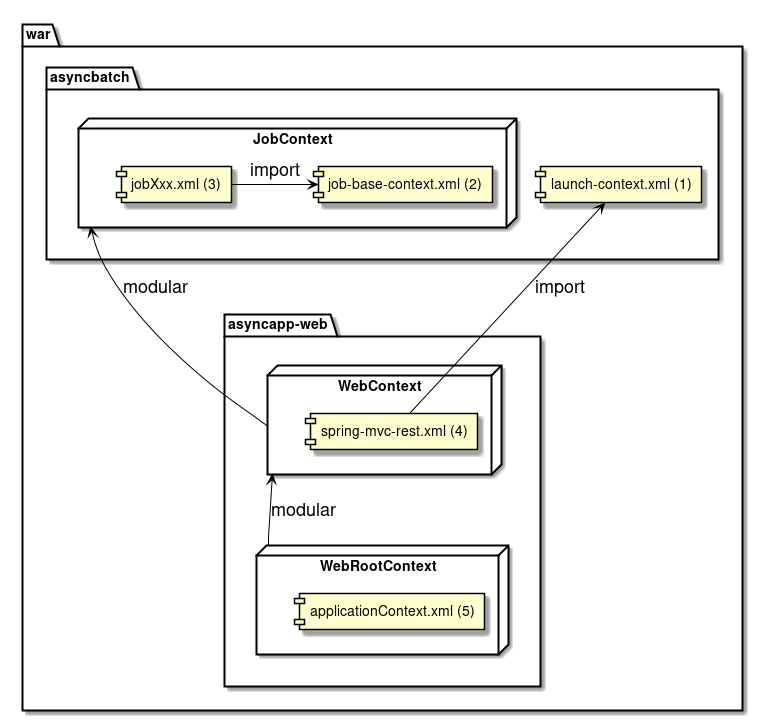

また、各ファイルの関連図を以下に示す。

3.1.4. 開発の流れ

ジョブを開発する一連の流れについて説明する。

ここでは、詳細な説明ではなく、大まかな流れを把握することを主眼とする。

3.1.4.2. アプリケーション全体の設定

ユーザの状況に応じて以下をカスタマイズする。

これら以外の設定をカスタマイズする方法については、個々の機能にて説明する。

3.1.4.2.1. pom.xmlのプロジェクト情報

プロジェクトのPOMには以下の情報が仮の値で設定されているため、状況に応じて設定すること。

-

プロジェクト名(name要素)

-

プロジェクト説明(description要素)

-

プロジェクトURL(url要素)

-

プロジェクト創設年(inceptionYear要素)

-

プロジェクトライセンス(licenses要素)

-

プロジェクト組織(organization要素)

3.1.4.2.2. データベース関連の設定

データベース関連の設定は複数箇所にあるため、それぞれを修正すること。

<!-- (1) -->

<dependency>

<groupId>com.h2database</groupId>

<artifactId>h2</artifactId>

<scope>runtime</scope>

</dependency>

<dependency>

<groupId>org.postgresql</groupId>

<artifactId>postgresql</artifactId>

<scope>runtime</scope>

</dependency># (2)

# Admin DataSource settings.

admin.jdbc.driver=org.h2.Driver

admin.jdbc.url=jdbc:h2:mem:batch-admin;DB_CLOSE_DELAY=-1

admin.jdbc.username=sa

admin.jdbc.password=

# (2)

# Job DataSource settings.

#jdbc.driver=org.postgresql.Driver

#jdbc.url=jdbc:postgresql://localhost:5432/postgres

#jdbc.username=postgres

#jdbc.password=postgres

jdbc.driver=org.h2.Driver

jdbc.url=jdbc:h2:mem:batch;DB_CLOSE_DELAY=-1

jdbc.username=sa

jdbc.password=

# (3)

# Spring Batch schema initialize.

data-source.initialize.enabled=true

spring-batch.schema.script=classpath:org/springframework/batch/core/schema-h2.sql

terasoluna-batch.commit.script=classpath:org/terasoluna/batch/async/db/schema-commit.sql<!-- (3) -->

<jdbc:initialize-database data-source="adminDataSource"

enabled="${data-source.initialize.enabled:false}"

ignore-failures="ALL">

<jdbc:script location="${spring-batch.schema.script}" />

<jdbc:script location="${terasoluna-batch.commit.script}" />

</jdbc:initialize-database>

<!-- (4) -->

<bean id="adminDataSource" class="org.apache.commons.dbcp2.BasicDataSource"

destroy-method="close"

p:driverClassName="${admin.jdbc.driver}"

p:url="${admin.jdbc.url}"

p:username="${admin.jdbc.username}"

p:password="${admin.jdbc.password}"

p:maxTotal="10"

p:minIdle="1"

p:maxWaitMillis="5000"

p:defaultAutoCommit="false"/>

<!-- (4) -->

<bean id="jobDataSource" class="org.apache.commons.dbcp2.BasicDataSource"

destroy-method="close"

p:driverClassName="${jdbc.driver}"

p:url="${jdbc.url}"

p:username="${jdbc.username}"

p:password="${jdbc.password}"

p:maxTotal="10"

p:minIdle="1"

p:maxWaitMillis="5000"

p:defaultAutoCommit="false" />

<!-- (5) -->

<bean id="jobSqlSessionFactory" class="org.mybatis.spring.SqlSessionFactoryBean"

p:dataSource-ref="jobDataSource" >

<property name="configuration">

<bean class="org.apache.ibatis.session.Configuration"

p:localCacheScope="STATEMENT"

p:lazyLoadingEnabled="true"

p:aggressiveLazyLoading="false"

p:defaultFetchSize="1000"

p:defaultExecutorType="REUSE" />

</property>

</bean><!-- (5) -->

<bean id="adminSqlSessionFactory" class="org.mybatis.spring.SqlSessionFactoryBean"

p:dataSource-ref="adminDataSource" >

<property name="configuration">

<bean class="org.apache.ibatis.session.Configuration"

p:localCacheScope="STATEMENT"

p:lazyLoadingEnabled="true"

p:aggressiveLazyLoading="false"

p:defaultFetchSize="1000"

p:defaultExecutorType="REUSE" />

</property>

</bean>| 項番 | 説明 |

|---|---|

(1) |

pom.xmlでは利用するデータベースへの接続に使用するJDBCドライバの依存関係を定義する。 |

(2) |

JDBCドライバの接続設定をする。 |

(3) |

Spring BatchやTERASOLUNA Batch 5.xが利用するデータベースの初期化処理を実行するか否か、および、利用するスクリプトを定義する。 |

(4) |

データソースの設定をする。 |

(5) |

MyBatisの挙動を設定する。 |

3.1.6. プロジェクトのビルドと実行

プロジェクトのビルドと実行について説明する。

3.1.6.1. アプリケーションのビルド

プロジェクトのルートディレクトリに移動し、以下のコマンドを発行する。

$ mvn clean dependency:copy-dependencies -DoutputDirectory=lib packageこれにより、以下が生成される。

-

<ルートディレクトリ>/target/<archetypeId>-<version>.jar

-

作成したバッチアプリケーションのJarが生成される

-

-

<ルートディレクトリ>/lib/(依存Jarファイル)

-

依存するJarファイル一式がコピーされる

-

試験環境や商用環境へ配備する際は、これらのJarファイルを任意のディレクトリにコピーすればよい。

3.1.6.2. 環境に応じた設定ファイルの切替

プロジェクトのpom.xmlでは、初期値として以下のProfileを設定している。

<profiles>

<!-- Including application properties and log settings into package. (default) -->

<profile>

<id>IncludeSettings</id>

<activation>

<activeByDefault>true</activeByDefault>

</activation>

<properties>

<exclude-property/>

<exclude-log/>

</properties>

</profile>

<!-- Excluding application properties and log settings into package. -->

<profile>

<id>ExcludeSettings</id>

<activation>

<activeByDefault>false</activeByDefault>

</activation>

<properties>

<exclude-property>batch-application.properties</exclude-property>

<exclude-log>logback.xml</exclude-log>

</properties>

</profile>

</profiles>ここでは、環境依存となる設定ファイルを含めるかどうかを切替ている。

この設定を活用して、環境配備の際に設定ファイルを別途配置することで環境差分を吸収することができる。

また、これを応用して、試験環境と商用環境でJarに含める設定ファイルを変えることもできる。

以下に、一例を示す。

<build>

<resources>

<resource>

<directory>src/main/resources</directory>

</resource>

<resource>

<directory>${project.root.basedir}/${project.config.resource.directory.rdbms}</directory>

</resource>

</resources>

</build>

<profiles>

<profile>

<id>postgresql9-local</id>

<activation>

<activeByDefault>true</activeByDefault>

</activation>

<dependencies>

<dependency>

<groupId>org.postgresql</groupId>

<artifactId>postgresql</artifactId>

<scope>runtime</scope>

</dependency>

</dependencies>

<properties>

<project.config.resource.directory.rdbms>config/rdbms/postgresql9/local</project.config.resource.directory.rdbms>

</properties>

</profile>

<profile>

<id>postgresql9-it</id>

<dependencies>

<dependency>

<groupId>org.postgresql</groupId>

<artifactId>postgresql</artifactId>

<scope>runtime</scope>

</dependency>

</dependencies>

<properties>

<project.config.resource.directory.rdbms>config/rdbms/postgresql9/it</project.config.resource.directory.rdbms>

</properties>

</profile>

</profiles>なお、MavenのProfileは以下の要領で、コマンド実行時に有効化することができる。

必要に応じて、複数Profileを有効化することもできる。必要に応じて、有効活用して欲しい。

$ mvn -P profile-1,profile-23.1.6.2.1. アプリケーションの実行

前段でビルドした結果を元に、ジョブを実行する例を示す。

archetypeIdとversionはユーザの環境に応じて読み替えて欲しい。

C:\xxxx> java -cp target\archetypeId-version.jar;lib\*^

org.springframework.batch.core.launch.support.CommandLineJobRunner^

META-INF/jobs/job01.xml job01$ java -cp 'target/archetypeId-version.jar:lib/*' \

org.springframework.batch.core.launch.support.CommandLineJobRunner \

META-INF/jobs/job01.xml job01|

javaコマンドが返却する終了コードをハンドリングする必要性

実際のシステムでは、

ジョブスケジューラからジョブを発行する際にjavaコマンドを直接発行するのではなく、

java起動用のシェルスクリプトを挟んで起動することが一般的である。 これはjavaコマンド起動前の環境変数を設定するためや、javaコマンドの終了コードをハンドリングするためである。

この、

以下に、終了コードのハンドリング例を示す。 終了コードのハンドリング例

|

3.2. チャンクモデルジョブの作成

3.2.1. Overview

チャンクモデルジョブの作成方法について説明する。 チャンクモデルのアーキテクチャについては、Spring Batchのアーキテクチャを参照のこと。

ここでは、チャンクモデルジョブの構成要素について説明する。

3.2.1.1. 構成要素

チャンクモデルジョブの構成要素を以下に示す。 これらの構成要素をBean定義にて組み合わせることで1つのジョブを実現する。

| 項番 | 名称 | 役割 | 設定必須 | 実装必須 |

|---|---|---|---|---|

1 |

ItemReader |

様々なリソースからデータを取得するためのインターフェース。 |

||

2 |

ItemProcessor |

入力から出力へデータを加工するためのインターフェース。 |

||

3 |

ItemWriter |

様々なリソースへデータを出力するためのインターフェース。 |

この表のポイントは以下である。

-

入力リソースから出力リソースへ単純にデータを移し替えるだけであれば、設定のみで実現できる。

-

ItemProcessorは、必要が生じた際にのみ実装すればよい。

以降、これらの構成要素を用いたジョブの実装方法について説明する。

3.2.2. How to use

ここでは、実際にチャンクモデルジョブを実装する方法について、以下の順序で説明する。

3.2.2.1. ジョブの設定

Bean定義ファイルにて、チャンクモデルジョブを構成する要素の組み合わせ方を定義する。 以下に例を示し、構成要素の繋がりを説明する。

<?xml version="1.0" encoding="UTF-8"?>

<beans xmlns="http://www.springframework.org/schema/beans"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xmlns:context="http://www.springframework.org/schema/context"

xmlns:batch="http://www.springframework.org/schema/batch"

xmlns:p="http://www.springframework.org/schema/p"

xmlns:mybatis="http://mybatis.org/schema/mybatis-spring"

xsi:schemaLocation="http://www.springframework.org/schema/beans http://www.springframework.org/schema/beans/spring-beans.xsd

http://www.springframework.org/schema/context http://www.springframework.org/schema/context/spring-context.xsd

http://www.springframework.org/schema/batch http://www.springframework.org/schema/batch/spring-batch.xsd

http://mybatis.org/schema/mybatis-spring http://mybatis.org/schema/mybatis-spring.xsd">

<!-- (1) -->

<import resource="classpath:META-INF/spring/job-base-context.xml"/>

<!-- (2) -->

<context:annotation-config/>

<!-- (3) -->

<context:component-scan

base-package="org.terasoluna.batch.functionaltest.app.common" />

<!-- (4) -->

<mybatis:scan

base-package="org.terasoluna.batch.functionaltest.app.repository.mst"

factory-ref="jobSqlSessionFactory"/>

<!-- (5) -->

<bean id="reader"

class="org.mybatis.spring.batch.MyBatisCursorItemReader" scope="step"

p:queryId="org.terasoluna.batch.functionaltest.app.repository.mst.CustomerRepository.findAll"

p:sqlSessionFactory-ref="jobSqlSessionFactory"/>

<!-- (6) -->

<!-- Item Processor -->

<!-- Item Processor in order that based on the Bean defined by the annotations, not defined here -->

<!-- (7) -->

<bean id="writer"

class="org.springframework.batch.item.file.FlatFileItemWriter"

scope="step"

p:resource="file:#{jobParameters[outputFile]}">

<property name="lineAggregator">

<bean class="org.springframework.batch.item.file.transform.DelimitedLineAggregator">

<property name="fieldExtractor">

<bean class="org.springframework.batch.item.file.transform.BeanWrapperFieldExtractor"

p:names="customerId,customerName,customerAddress,customerTel,chargeBranchId"/>

</property>

</bean>

</property>

</bean>

<!-- (8) -->

<batch:job id="jobCustomerList01" job-repository="jobRepository"> <!-- (9) -->

<batch:step id="jobCustomerList01.step01"> <!-- (10) -->

<batch:tasklet transaction-manager="jobTransactionManager"> <!-- (11) -->

<batch:chunk reader="reader"

processor="processor"

writer="writer"

commit-interval="10" /> <!-- (12) -->

</batch:tasklet>

</batch:step>

</batch:job>

</beans>@Component("processor") // (6)

public class CustomerProcessor implement ItemProcessor<Customer, Customer> {

// omitted

}| 項番 | 説明 |

|---|---|

(1) |

TERASOLUNA Batch 5.xを利用する際に、常に必要なBean定義を読み込む設定をインポートする。 |

(2) |

アノテーションによるBean定義の有効化を行う。ItemProcessorやListenerなどを実装する際に、(3)と合わせて利用する。 |

(3) |

コンポーネントスキャン対象のベースパッケージを設定する。アノテーションによるBean定義を行う場合は、(2)と合わせて利用する。 |

(5) |

ItemReaderの設定。 |

(6) |

ItemProcessorは、(2),(3)によりアノテーションにて定義することができ、Bean定義ファイルで定義する必要がない。 |

(7) |

ItemWriterの設定。 |

(8) |

ジョブの設定。 |

(9) |

|

(10) |

ステップの設定。 |

(11) |

タスクレットの設定。 |

(12) |

チャンクモデルジョブの設定。 |

|

commit-intervalのチューニング

前述の例では10件としているが、利用できるマシンリソースやジョブの特性によって適切な件数は異なる。 複数のリソースにアクセスしてデータを加工するジョブであれば10件から100件程度で処理スループットが頭打ちになることもある。 一方、入出力リソースが1:1対応しておりデータを移し替える程度のジョブであれば5000件や10000件でも処理スループットが伸びることがある。 ジョブ実装時の |

3.2.2.2. コンポーネントの実装

ここでは主に、ItemProcessorを実装する方法について説明する。

他のコンポーネントについては、以下を参照のこと。

-

ItemReader、ItemWriter

-

Listener

3.2.2.2.1. ItemProcessorの実装

ItemProcessorの実装方法を説明する。

ItemProcessorは、以下のインターフェースが示すとおり、入力リソースから取得したデータ 1件 を元に、 出力リソースに向けたデータ 1件 を作成する役目を担う。 つまり、ItemProcessorはデータ 1件 に対するビジネスロジックを実装する箇所、と言える。

public interface ItemProcessor<I, O> {

O process(I item) throws Exception;

}なお、インターフェースが示すIとOは以下のとおり同じ型でも異なる型でもよい。

同じ型であれば入力データを一部修正することを意味し、

異なる型であれば入力データを元に出力データを生成することを意味する。

@Component

public class AmountUpdateItemProcessor implements

ItemProcessor<SalesPlanDetail, SalesPlanDetail> {

@Override

public SalesPlanDetail process(SalesPlanDetail item) throws Exception {

item.setAmount(new BigDecimal("1000"));

return item;

}

}@Component

public class UpdateItemFromDBProcessor implements

ItemProcessor<SalesPerformanceDetail, SalesPlanDetail> {

@Inject

CustomerRepository customerRepository;

@Override

public SalesPlanDetail process(SalesPerformanceDetail readItem) throws Exception {

Customer customer = customerRepository.findOne(readItem.getCustomerId());

SalesPlanDetail writeItem = new SalesPlanDetail();

writeItem.setBranchId(customer.getChargeBranchId());

writeItem.setYear(readItem.getYear());

writeItem.setMonth(readItem.getMonth());

writeItem.setCustomerId(readItem.getCustomerId());

writeItem.setAmount(readItem.getAmount());

return writeItem;

}

}|

ItemProcessorからnullを返却することの意味

ItemProcessorからnullを返却することは、当該データを後続処理(Writer)に渡さないことを意味し、 言い換えるとデータをフィルタすることになる。 これは、入力データの妥当性検証を実施する上で有効活用できる。 詳細については、入力チェックを参照のこと。 |

|

ItemProcessorの処理スループットをあげるには

前述した実装例のように、ItemProcessorの実装クラスではDBやファイルを始めとしたリソースにアクセスしなければならないことがある。 ItemProcessorは入力データ1件ごとに実行されるため、I/Oが少しでも発生するとジョブ全体では大量のI/Oが発生することになる。 そのため、極力I/Oを抑えることが処理スループットをあげる上で重要となる。 1つの方法として、後述のListenerを活用することで事前に必要なデータをメモリ上に確保しておき、 ItemProcessorにおける処理の大半を、CPU/メモリ間で完結するように実装する手段がある。 ただし、1ジョブあたりのメモリを大量に消費することにも繋がるので、何でもメモリ上に確保すればよいわけではない。 I/O回数やデータサイズを元に、メモリに格納するデータを検討すること。 この点については、データの入出力でも紹介する。 |

|

複数のItemProcessorを同時に利用する

汎用的なItemProcessorを用意し、個々のジョブに適用したい場合は、

Spring Batchが提供する CompositeItemProcessorによる複数ItemProcessorの連結

delegates属性に指定した順番に処理されることに留意すること。 |

3.3. タスクレットモデルジョブの作成

3.3.1. Overview

タスクレットモデルジョブの作成方法について説明する。 タスクレットモデルのアーキテクチャについては、Spring Batchのアーキテクチャを参照のこと。

3.3.2. How to use

ここでは、実際にタスクレットモデルジョブを実装する方法について、以下の順序で説明する。

3.3.2.1. ジョブの設定

Bean定義ファイルにて、タスクレットモデルジョブを定義する。 以下に例を示す。

<?xml version="1.0" encoding="UTF-8"?>

<beans xmlns="http://www.springframework.org/schema/beans"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xmlns:context="http://www.springframework.org/schema/context"

xmlns:batch="http://www.springframework.org/schema/batch"

xsi:schemaLocation="http://www.springframework.org/schema/beans http://www.springframework.org/schema/beans/spring-beans.xsd

http://www.springframework.org/schema/context http://www.springframework.org/schema/context/spring-context.xsd

http://www.springframework.org/schema/batch http://www.springframework.org/schema/batch/spring-batch.xsd">

<!-- (1) -->

<import resource="classpath:META-INF/spring/job-base-context.xml"/>

<!-- (2) -->

<context:annotation-config/>

<!-- (3) -->

<context:component-scan

base-package="org.terasoluna.batch.functionaltest.app.common"/>

<!-- (4) -->

<batch:job id="jobSimpleJob" job-repository="jobRepository"> <!-- (5) -->

<batch:step id="simpleJob.step01"> <!-- (6) -->

<batch:tasklet transaction-manager="jobTransactionManager"

ref="simpleJobTasklet"/> <!-- (7) -->

</batch:step>

</batch:job>

</beans>package org.terasoluna.batch.functionaltest.app.common;

@Component // (3)

public class SimpleJobTasklet implements Tasklet {

// omitted

}| 項番 | 説明 |

|---|---|

(1) |

TERASOLUNA Batch 5.xを利用する際に、常に必要なBean定義を読み込む設定をインポートする。 |

(2) |

アノテーションによるBean定義の有効化を行う。(3)と合わせて利用する。 |

(3) |

コンポーネントスキャン対象のベースパッケージを設定する。(2)と合わせて利用する。 |

(4) |

ジョブの設定。 |

(5) |

|

(6) |

ステップの設定。 |

(7) |

タスクレットの設定。 また、 |

|

アノテーション利用時のBean名

|

3.3.2.3. シンプルなTaskletの実装

ログを出力するのみのTasklet実装を通じ、最低限のポイントを説明する。

package org.terasoluna.batch.functionaltest.app.common;

// omitted

@Component

public class SimpleJobTasklet implements Tasklet { // (1)

private static final Logger logger =

LoggerFactory.getLogger(SimpleJobTasklet.class);

@Override

public RepeatStatus execute(StepContribution contribution,

ChunkContext chunkContext) throws Exception { // (2)

logger.info("called tasklet."); // (3)

return RepeatStatus.FINISHED; // (4)

}

}| 項番 | 説明 |

|---|---|

(1) |

|

(2) |

|

(3) |

任意の処理を実装する。ここではINFOログを出力している。 |

(4) |

Taskletの処理が完了したかどうかを返却する。 |

3.3.2.4. チャンクモデルのコンポーネントを利用するTasklet実装

Spring Batch では、Tasklet実装の中でチャンクモデルの各種コンポーネントを利用することに言及していない。 TERASOLUNA Batch 5.xでは、以下のような状況に応じてこれを選択可能してよい。

-

複数のリソースを組み合わせながら処理するため、チャンクモデルの形式に沿いにくい

-

チャンクモデルでは処理が複数箇所に実装することになるため、タスクレットモデルの方が全体像を把握しやすい

-

リカバリをシンプルにするため、チャンクモデルの中間コミットではなく、タスクレットモデルの一括コミットを使いたい

以下に、チャンクモデルのコンポーネントであるItemReaderやItemWriterを利用するTasklet実装について説明する。

@Component()

@Scope("step") // (1)

public class SalesPlanChunkTranTask implements Tasklet {

@Inject

@Named("detailCSVReader") // (2)

ItemStreamReader<SalesPlanDetail> itemReader; // (3)

@Inject

SalesPlanDetailRepository repository; // (4)

@Override

public RepeatStatus execute(StepContribution contribution,

ChunkContext chunkContext) throws Exception {

SalesPlanDetail item;

try {

itemReader.open(chunkContext.getStepContext().getStepExecution()

.getExecutionContext()); // (5)

while ((item = itemReader.read()) != null) { // (6)

// do some processes.

repository.create(item); // (7)

}

} finally {

itemReader.close(); // (8)

}

return RepeatStatus.FINISHED;

}

}<!-- omitted -->

<import resource="classpath:META-INF/spring/job-base-context.xml"/>

<context:annotation-config/>

<context:component-scan

base-package="org.terasoluna.batch.functionaltest.app.plan" />

<context:component-scan

base-package="org.terasoluna.batch.functionaltest.ch05.transaction.component" />

<!-- (9) -->

<mybatis:scan

base-package="org.terasoluna.batch.functionaltest.app.repository.plan"

factory-ref="jobSqlSessionFactory"/>

<!-- (10) -->

<bean id="detailCSVReader"

class="org.springframework.batch.item.file.FlatFileItemReader" scope="step"

p:resource="file:#{jobParameters[inputFile]}">

<property name="lineMapper">

<bean class="org.springframework.batch.item.file.mapping.DefaultLineMapper">

<property name="lineTokenizer">

<bean class="org.springframework.batch.item.file.transform.DelimitedLineTokenizer"

p:names="branchId,year,month,customerId,amount"/>

</property>

<property name="fieldSetMapper">

<bean class="org.springframework.batch.item.file.mapping.BeanWrapperFieldSetMapper"

p:targetType="org.terasoluna.batch.functionaltest.app.model.plan.SalesPlanDetail"/>

</property>

</bean>

</property>

</bean>

<!-- (11) -->

<batch:job id="createSalesPlanChunkTranTask" job-repository="jobRepository">

<batch:step id="createSalesPlanChunkTranTask.step01">

<batch:tasklet transaction-manager="jobTransactionManager"

ref="salesPlanChunkTranTask"/>

</batch:step>

</batch:job>| 項番 | 説明 |

|---|---|

(1) |

本クラス内で利用するItemReaderのBeanスコープに合わせ、stepスコープとする。 |

(2) |

入力リソース(この例ではフラットファイル)へのアクセスは |

(3) |

|

(4) |

出力リソース(この例ではデータベース)へのアクセスはMyBatisのMapperを通じて行う。 |

(5) |

入力リソースをオープンする。 |

(6) |

入力リソース全件を逐次ループ処理する。 |

(7) |

データベースへ出力する。 |

(8) |

リソースは必ずクローズすること。 |

(9) |

データベースへ出力するため、 |

(10) |

ファイルから入力するため、 |

(11) |

各種コンポーネントはアノテーションによって解決するため、 |

|

スコープの統一について

Tasklet実装クラスと、InjectするBeanのスコープは、同じスコープに統一すること。 たとえば、 仮にTasklet実装クラスのスコープを |

|

@Injectを付与するフィールドの型について

利用する実装クラスに応じて、以下のいずれかとする。

必ずjavadocを確認してどちらを利用するか判断すること。以下に代表例を示す。

|

もう1つの例として、ItemReaderとItemWriterを同時に用いた場合を示す。

@Component

@Scope("step")

public class SalesPerformanceTasklet implements Tasklet {

@Inject

ItemStreamReader<SalesPerformanceDetail> reader;

@Inject

ItemWriter<SalesPerformanceDetail> writer; // (1)

int chunkSize = 10; // (2)

@Override

public RepeatStatus execute(StepContribution contribution,

ChunkContext chunkContext) throws Exception {

try {

reader.open(chunkContext.getStepContext().getStepExecution()

.getExecutionContext());

List<SalesPerformanceDetail> items = new ArrayList<>(chunkSize); // (2)

SalesPerformanceDetail item = null;

do {

// Pseudo operation of ItemReader

for (int i = 0; i < chunkSize; i++) { // (3)

item = reader.read();

if (item == null) {

break;

}

// Pseudo operation of ItemProcessor

// do some processes.

items.add(item);

}

// Pseudo operation of ItemWriter

if (!items.isEmpty()) {

writer.write(items); // (4)

items.clear();

}

} while (item != null);

} finally {

try {

reader.close();

} catch (Exception e) {

// do nothing.

}

}

return RepeatStatus.FINISHED;

}

}<!-- omitted -->

<import resource="classpath:META-INF/spring/job-base-context.xml"/>

<context:annotation-config/>

<context:component-scan

base-package="org.terasoluna.batch.functionaltest.app.common,

org.terasoluna.batch.functionaltest.app.performance,

org.terasoluna.batch.functionaltest.ch06.exceptionhandling"/>

<mybatis:scan

base-package="org.terasoluna.batch.functionaltest.app.repository.performance"

factory-ref="jobSqlSessionFactory"/>

<bean id="detailCSVReader"

class="org.springframework.batch.item.file.FlatFileItemReader" scope="step"

p:resource="file:#{jobParameters[inputFile]}">

<property name="lineMapper">

<bean class="org.springframework.batch.item.file.mapping.DefaultLineMapper">

<property name="lineTokenizer">

<bean class="org.springframework.batch.item.file.transform.DelimitedLineTokenizer"

p:names="branchId,year,month,customerId,amount"/>

</property>

<property name="fieldSetMapper">

<bean class="org.springframework.batch.item.file.mapping.BeanWrapperFieldSetMapper"

p:targetType="org.terasoluna.batch.functionaltest.app.model.performance.SalesPerformanceDetail"/>

</property>

</bean>

</property>

</bean>

<!-- (1) -->

<bean id="detailWriter"

class="org.mybatis.spring.batch.MyBatisBatchItemWriter"

p:statementId="org.terasoluna.batch.functionaltest.app.repository.performance.SalesPerformanceDetailRepository.create"

p:sqlSessionTemplate-ref="batchModeSqlSessionTemplate"/>

<batch:job id="jobSalesPerfTasklet" job-repository="jobRepository">

<batch:step id="jobSalesPerfTasklet.step01">

<batch:tasklet ref="salesPerformanceTasklet"

transaction-manager="jobTransactionManager"/>

</batch:step>

</batch:job>| 項番 | 説明 |

|---|---|

(1) |

|

(2) |

|

(3) |

チャンクモデルの動作にそって、 |

(4) |

|

ItemReaderやItemWriterの実装クラスを利用するかどうかは都度判断してほしいが、

ファイルアクセスはItemReaderやItemWriterの実装クラスを利用するとよいだろう。

それ以外のデータベースアクセス等は無理に使う必要はない。性能向上のために使えばよい。

3.4. チャンクモデルとタスクレットモデルの使い分け

ここでは、チャンクモデルとタスクレットモデルの使い分けについて、それぞれの特徴を整理することで説明する。 なお、説明において、以降の章で詳細な説明をする事項もあるため、適宜対応する章を参照して欲しい。

また、以降の内容は考え方の一例として捉えて欲しい。制約や推奨事項ではない。 ユーザやシステムの特性に応じてジョブを作成する際の参考にしてほしい。

以下に、チャンクモデルとタスクレットモデルの主要な違いについて列挙する。

| 項目 | チャンク | タスクレット |

|---|---|---|

構成要素 |

|

|

トランザクション |

一定件数で中間コミットを発行しながら処理することが基本となる。一括コミットはできない。 |

全体で一括コミットにて処理することが基本となる。中間コミットはユーザにて実装する必要がある。 |

リスタート |

件数ベースのリスタートができる。 |

件数ベースのリスタートはできない。 |

これを踏まえて、以下にそれぞれを使い分ける例をいくつか紹介する。

- リカバリを限りなくシンプルにしたい

-

エラーとなったジョブは対象のジョブをリランするのみで復旧したい場合など、 リカバリをシンプルにしたい時はタスクレットモデルを選択するとよい。

チャンクモデルでは処理済データをジョブ実行前の状態に戻したり、 未処理データのみ処理するようジョブを予め作りこんでおいたり、 といった対処が必要となる。 - 処理の内容をまとめたい

-

1ジョブ1クラスなど、ジョブの見通しを優先したい場合はタスクレットを選択するとよい。

- 大量のデータを安定して処理したい

-

1000万件など、一括処理するとリソースに影響する件数を対象とする際はチャンクモデルを活用するか検討するとよい。 これは中間コミットによって安定させることを意味する。 タスクレットモデルでも中間コミットを打つことが可能だが、チャンクモデルの方がシンプルな実装になる可能性がある。

- エラー後の復旧は件数ベースリスタートとしたい

-

バッチウィンドウがシビアであり、エラーとなったデータ以降から再開したい場合に、 Spring Batchが提供する件数ベースリスタートを活用するときは、チャンクモデルを選択する必要がある。 これにより、個々のジョブでその仕組を作りこむ必要がなくなる。

|

チャンクモデルとタスクレットモデルは、併用することが基本である。 たとえば、大部分は処理件数や処理時間に余裕があるならばタスクレットモデルを基本とし、 極少数の大量件数を処理するジョブはチャンクモデルを選択する、といったことは自然といえる。 |

4. ジョブの起動

4.1. 同期実行

4.1.1. Overview

同期実行について説明する。 同期実行とは、ジョブスケジューラなどによりシェルを介して新規プロセスとして起動し、ジョブの実行結果を呼び出し元に返却する実行方法である。

本機能は、チャンクモデルとタスクレットモデルとで同じ使い方になる。

4.1.2. How to use

CommandLineJobRunnerによってジョブを起動する方法を説明する。

なお、アプリケーションのビルドや実行については、プロジェクトの作成を参照のこと。 また、起動パラメータの指定方法や活用方法については、ジョブの起動パラメータを参照のこと。 これらと本節の説明は一部重複するが、同期実行の要素に注目して説明する。

4.1.2.1. 実行方法

TERASOLUNA Batch 5.xにおいて、同期実行は Spring Batch が提供するCommandLineJobRunnerによって実現する。

CommandLineJobRunnerは、以下の要領にてjavaコマンドを発行することで起動する。

$ java org.springframework.batch.core.launch.support.CommandLineJobRunner <jobPath> <options> <jobIdentifier> <jobParameters>| 指定する項目 | 説明 | 必須 |

|---|---|---|

jobPath |

起動するジョブの設定を記述したBean定義ファイルのパス。classpathからの相対パスにて指定する。 |

|

options |

起動する際の各種オプション(停止、リスタートなど)を指定する。 |

|

jobIdentifier |

ジョブの識別子として、Bean定義上のジョブ名、もしくはジョブを実行後のジョブ実行IDを指定する。 通常はジョブ名を指定する。ジョブ実行IDは停止やリスタートの際にのみ指定する。 |

|

jobParameters |

ジョブの引数を指定する。指定は |

以下に、必須項目のみを指定した場合の実行例を示す。

$ java -cp 'target/archetypeId-version.jar:lib/*' \ # (1)

org.springframework.batch.core.launch.support.CommandLineJobRunner \ # (2)

META-INF/jobs/job01.xml job01 # (3)<batch:job id="job01" job-repository="jobRepository"> <!-- (3) -->

<batch:step id="job01.step01">

<batch:tasklet transaction-manager="jobTransactionManager">

<batch:chunk reader="employeeReader"

processor="employeeProcessor"

writer="employeeWriter" commit-interval="10" />

</batch:tasklet>

</batch:step>

</batch:job>| 項番 | 説明 |

|---|---|

(1) |

|

(2) |

起動するクラスに、 |

(3) |

|

次に、任意項目として起動パラメータを指定した場合の実行例を示す。

$ java -cp 'target/archetypeId-version.jar:lib/*' \

org.springframework.batch.core.launch.support.CommandLineJobRunner \

META-INF/jobs/setupJob.xml setupJob target=server1 outputFile=/tmp/result.csv # (1)| 項番 | 説明 |

|---|---|

(1) |

ジョブの起動パラメータとして、 |

4.1.2.2. 任意オプション

CommandLineJobRunnerの構文で示した任意のオプションについて補足する。

CommandLineJobRunnerでは以下の4つの起動オプションが使用できる。

ここでは個々の説明は他に委ねることとし、概要のみ説明する。

- -restart

-

失敗したジョブを再実行する。詳細は、処理の再実行を参照のこと。

- -stop

-

実行中のジョブを停止する。詳細は、ジョブの管理を参照のこと。

- -abandon

-

停止されたジョブを放棄する。放棄されたジョブは再実行不可となる。 TERASOLUNA Batch 5.xでは、このオプションを活用するシーンがないため、説明を割愛する。

- -next

-

過去に一度実行完了したジョブを再度実行する。ただし、TERASOLUNA Batch 5.xでは、このオプションを利用しない。

なぜなら、TERASOLUNA Batch 5.xでは、Spring Batchのデフォルトである「同じパラメータで起動したジョブは同一ジョブとして認識され、同一ジョブは1度しか実行できない」 という制約を回避しているためである。

詳細はパラメータ変換クラスについてにて説明する。

また、本オプションを利用するには、JobParametersIncrementerというインターフェースの実装クラスが必要だが、 TERASOLUNA Batch 5.xでは設定を行っていない。

そのため、本オプションを指定して起動すると、必要なBean定義が存在しないためエラーとなる。

4.2. ジョブの起動パラメータ

4.2.1. Overview

本節では、ジョブの起動パラメータ(以降、パラメータ)の利用方法について説明する。

本機能は、チャンクモデルとタスクレットモデルとで同じ使い方になる。

パラメータは、以下のような実行環境や実行タイミングに応じてジョブの動作を柔軟に切替える際に使用する。

-

処理対象のファイルパス

-

システムの運用日時

パラメータを与える方法は、以下のとおりである。

指定したパラメータは、Bean定義やSpring管理下のJavaで参照できる。

4.2.2. How to use

4.2.2.1. パラメータ変換クラスについて

Spring Batchでは、受け取ったパラメータを以下の流れで処理する。

-

JobParametersConverterの実装クラスがJobParametersに変換する。 -

Bean定義やSpring管理下のJavaにて

JobParametersからパラメータを参照する。

前述したJobParametersConverterの実装クラスは複数提供されている。

以下にそれぞれの特徴を示す。

-

DefaultJobParametersConverter

-

パラメータのデータ型を指定することができる(String、Long、Date、Doubleの4種類)。

-

-

JsrJobParametersConverter

-

パラメータのデータ型を指定することができない(Stringのみ)。

-

パラメータにジョブ実行を識別するID(RUN_ID)を

jsr_batch_run_idという名称で自動的に付与する。-

RUN_IDは、ジョブが実行される都度増分する。増分は、データベースのSEQUENCE(名称は

JOB_SEQとなる)を利用するため、重複することがない。 -

Spring Batchでは、同じパラメータで起動したジョブは同一ジョブとして認識され、同一ジョブは1度しか実行できない、という仕様がある。 これに対し、

jsr_batch_run_idという名称のパラメータを一意な値で付加することにより、別のジョブと認識する仕組みとなっている。 詳細は、Spring Batchのアーキテクチャを参照すること。

-

-

Spring BatchではBean定義で使用するJobParametersConverterの実装クラスを指定しない場合、DefaultJobParametersConverterが使用される。

しかし、TERASOLUNA Batch 5.xでは以下の理由によりDefaultJobParametersConverterは採用しない。

-

1つのジョブを同じパラメータによって、異なるタイミングで起動することは一般的である。

-

起動時刻のタイムスタンプなどを指定し、異なるジョブとして管理することも可能だが、それだけのためにジョブパラメータを指定するのは煩雑である。

-

DefaultJobParametersConverterはパラメータに対しデータ型を指定することができるが、型変換に失敗した場合のハンドリングが煩雑になる。

TERASOLUNA Batch 5.xでは、JsrJobParametersConverterを利用することで、ユーザが意識することなく自動的にRUN_IDを付与している。

この仕組みにより、ユーザから見ると同一ジョブをSpring Batchとしては異なるジョブとして扱っている。

TERASOLUNA Batch 5.xでは、予めlaunch-context.xmlにてJsrJobParametersConverterを使用するように設定している。

そのためTERASOLUNA Batch 5.xを推奨設定で使用する場合はJobParametersConverterの設定を行う必要はない。

<bean id="jobParametersConverter"

class="org.springframework.batch.core.jsr.JsrJobParametersConverter"

c:dataSource-ref="adminDataSource" />

<bean id="jobOperator"

class="org.springframework.batch.core.launch.support.SimpleJobOperator"

p:jobRepository-ref="jobRepository"

p:jobRegistry-ref="jobRegistry"

p:jobExplorer-ref="jobExplorer"

p:jobParametersConverter-ref="jobParametersConverter"

p:jobLauncher-ref="jobLauncher" />以降はJsrJobParametersConverterを利用する前提で説明する。

4.2.2.2. コマンドライン引数から与える

まず、もっとも基本的な、コマンドライン引数から与える方法について説明する。

コマンドライン引数としてCommandLineJobRunnerの第3引数以降に<パラメータ名>=<値>形式で列挙する。

パラメータの個数や長さは、Spring BatchやTERASOLUNA Batch 5.xにおいては制限がない。

しかし、OSにはコマンド引数の長さに制限がある。

そのため、あまりに大量の引数が必要な場合は、ファイルから標準入力へリダイレクトするや

パラメータとプロパティの併用などの方法を活用すること。

# Execute job

$ java org.springframework.batch.core.launch.support.CommandLineJobRunner \

JobDefined.xml JOBID param1=abc outputFileName=/tmp/result.csv以下のように、Bean定義またはJavaで参照することができる。

-

Bean定義で参照する

-

#{jobParamaters[xxx]}で参照可能

-

-

Javaで参照する

-

@Value("#{jobParameters[xxx]}")で参照可能

-

|

JobParametersを参照するBeanのスコープはStepスコープでなければならない

late bindingとはその名のとおり、遅延して値を設定することである。

Spring Frameworkの なお、 |

|

Stepスコープの指定では@StepScopeアノテーションは使用できない

Spring Batchでは、 そのため、TERASOLUNA Batch 5.xにおける

|

<!-- (1) -->

<bean id="reader"

class="org.springframework.batch.item.file.FlatFileItemReader" scope="step"

p:resource="file:#{jobParameters[inputFile]}"> <!-- (2) -->

<property name="lineMapper">

<!-- omitted settings -->

</property>

</bean>| 項番 | 説明 |

|---|---|

(1) |

beanタグにscope属性としてスコープを指定する。 |

(2) |

参照するパラメータを指定する。 |

@Component

@Scope("step") // (1)

public class ParamRefInJavaTasklet implements Tasklet {

/**

* Holds a String type value

*/

@Value("#{jobParameters[str]}") // (2)

private String str;

// omitted execute()

}| 項番 | 説明 |

|---|---|

(1) |

クラスに |

(2) |

|

4.2.2.3. ファイルから標準入力へリダイレクトする

ファイルから標準入力へリダイレクトする方法について説明する。

パラメータは下記のようにファイルに定義する。

param1=abc

outputFile=/tmp/result.csvコマンドライン引数としてパラメータを定義したファイルをリダイレクトする。

# Execute job

$ java org.springframework.batch.core.launch.support.CommandLineJobRunner \

JobDefined.xml JOBID < params.txtパラメータの参照方法はコマンドライン引数から与える方法と同様である。

4.2.2.4. パラメータのデフォルト値を設定する

パラメータを任意とした場合、以下の形式でデフォルト値を設定することができる。

-

#{jobParameters[パラメータ名] ?: デフォルト値}

ただし、パラメータを使用して値を設定している項目であるということは、デフォルト値もパラメータと同様に環境や実行タイミングによって異なる可能性がある。

まずは、デフォルト値をソースコード上にハードコードをする方法を説明する。 しかし、後述のパラメータとプロパティの併用を活用する方が適切なケースが多いため、合わせて参照すること。

該当するパラメータが設定されなかった場合にデフォルト値に設定した値が参照される。

<!-- (1) -->

<bean id="reader"

class="org.springframework.batch.item.file.FlatFileItemReader" scope="step"

p:resource="file:#{jobParamaters[inputFile] ?: /input/sample.csv}"> <!-- (2) -->

<property name="lineMapper">

// omitted settings

</property>

</bean>| 項番 | 説明 |

|---|---|

(1) |

beanタグにscope属性としてスコープを指定する。 |

(2) |

参照するパラメータを指定する。 |

@Component

@Scope("step") // (1)

public class ParamRefInJavaTasklet implements Tasklet {

/**

* Holds a String type value

*/

@Value("#{jobParameters[str] ?: xyz}") // (2)

private String str;

// omitted execute()

}| 項番 | 説明 |

|---|---|

(1) |

クラスに |

(2) |

|

4.2.2.5. パラメータの妥当性検証

オペレーションミスや意図しない挙動を防ぐために、ジョブの起動時にパラメータの妥当性検証が必要となる場合もある。

パラメータの妥当性検証はSpring Batchが提供するJobParametersValidatorを活用することで実現可能である。

パラメータはItemReader/ItemProcessor/ItemWriterといった様々な場所で参照するため、 ジョブの起動直後に妥当性検証が行われる。

パラメータの妥当性を検証する方法は2つあり、検証の複雑度によって異なる。

4.2.2.5.1. 簡易な妥当性検証

Spring BatchはJobParametersValidatorのデフォルト実装として、DefaultJobParametersValidatorを提供している。

このバリデータでは設定により以下を検証することができる。

-

必須パラメータが設定されていること

-

必須または任意パラメータ以外のパラメータが指定されていないこと

以下に定義例を示す。

<!-- (1) -->

<bean id="jobParametersValidator"

class="org.springframework.batch.core.job.DefaultJobParametersValidator">

<property name="requiredKeys"> <!-- (2) -->

<list>

<value>jsr_batch_run_id</value> <!-- (3) -->

<value>inputFileName</value>

<value>outputFileName</value>

</list>

</property>

<property name="optionalKeys"> <!-- (4) -->

<list>

<value>param1</value>

<value>param2</value>

</list>

</property>

</bean>

<batch:job id="jobUseDefaultJobParametersValidator" job-repository="jobRepository">

<batch:step id="jobUseDefaultJobParametersValidator.step01">

<batch:tasklet ref="sampleTasklet" transaction-manager="jobTransactionManager"/>

</batch:step>

<batch:validator ref="jobParametersValidator"/> <!-- (5) -->

</batch:job>| 項番 | 説明 |

|---|---|

(1) |

|

(2) |

必須パラメータはプロパティ |

(3) |

必須パラメータに |

(4) |

任意パラメータはプロパティ |

(5) |

jobタグ内にvalidatorタグを使用してジョブにバリデータを適用する。 |

|

TERASOLUNA Batch 5.xでは省略できない必須パラメータ

TERASOLUNA Batch 5.xではパラメータ変換に

そのため、 パラメータの定義例

|

DefaultJobParametersValidatorにて検証可能な条件の理解を深めるため、検証結果がOKとなる場合とNGとなる場合の例を示す。

<bean id="jobParametersValidator"

class="org.springframework.batch.core.job.DefaultJobParametersValidator"

p:requiredKeys="outputFileName"

p:optionalKeys="param1"/># Execute job

$ java org.springframework.batch.core.launch.support.CommandLineJobRunner \

JobDefined.xml JOBID param1=aaa必須パラメータoutputFileが設定されていないためNGとなる。

# Execute job

$ java org.springframework.batch.core.launch.support.CommandLineJobRunner \

JobDefined.xml JOBID outputFileName=/tmp/result.csv param2=aaa必須パラメータ、任意パラメータのどちらにも指定されていないパラメータparam2が設定されたためNGとなる。

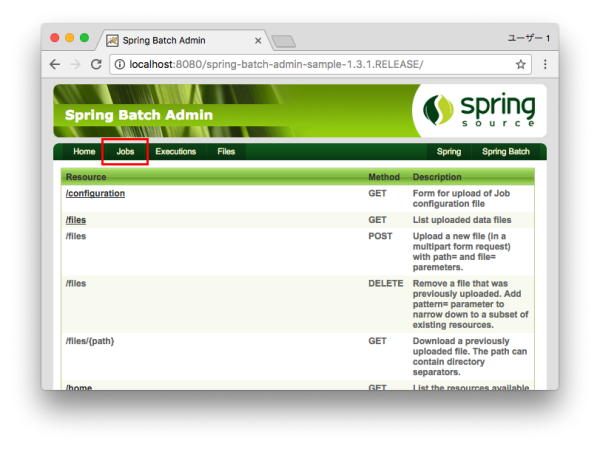

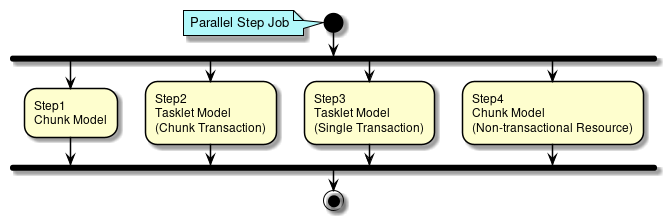

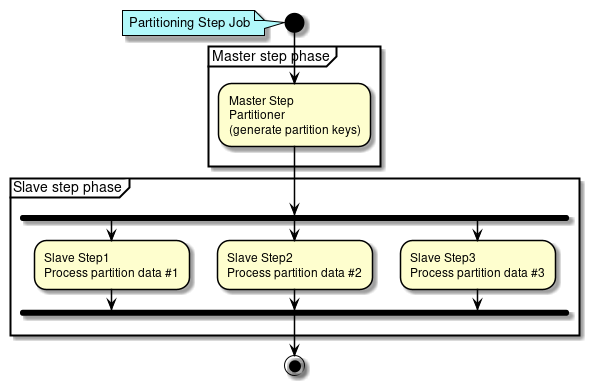

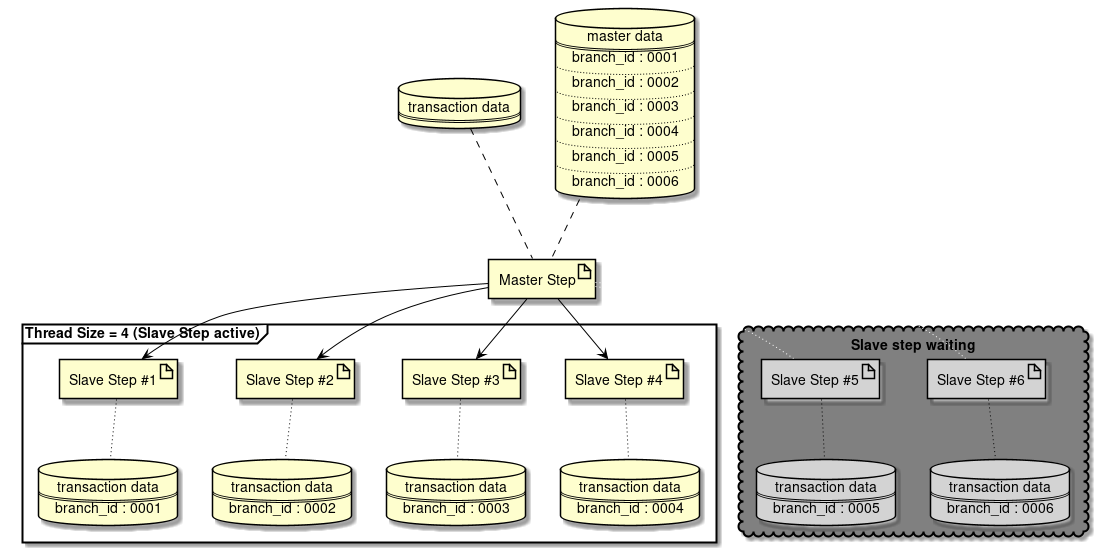

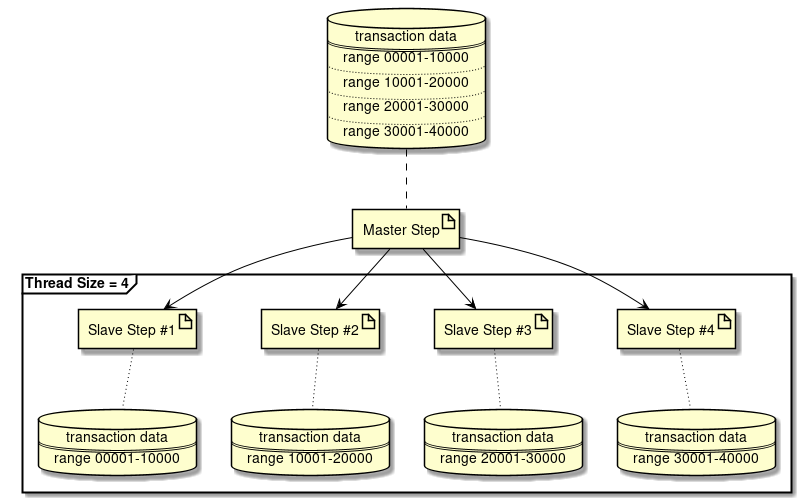

# Execute job